IRIS 2024.3 で発生する2つの製品障害が確認されました。お使いの環境が該当する場合は、それぞれの解決方法にしたがってご対応いただきますよう、よろしくお願いします。

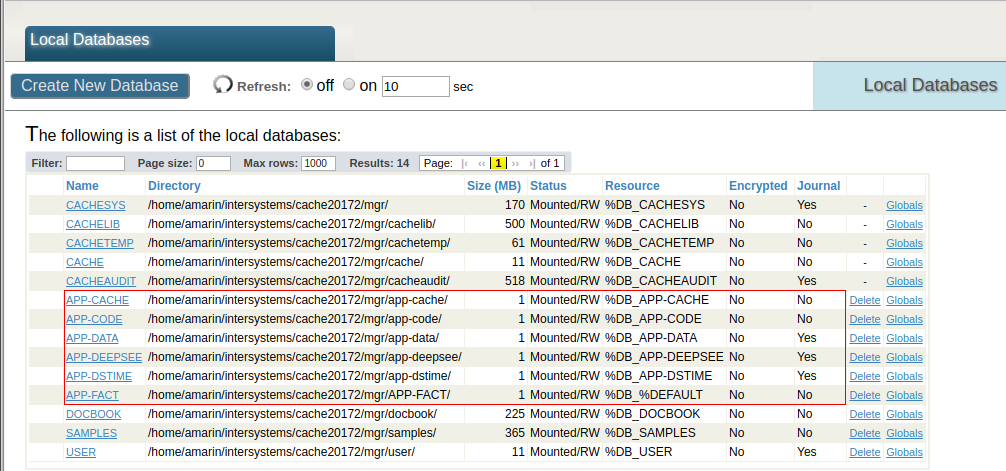

InterSystemsCachГ©データベースは、すべてのデータ、アプリケーションスクリプトならびにユーザー、ロールおよびセキュリティ構成が保存されるファイルです。 通常、ファイルの名前は cache.dat です。 ドキュメント。

InterSystemsCachГ©データベースは、すべてのデータ、アプリケーションスクリプトならびにユーザー、ロールおよびセキュリティ構成が保存されるファイルです。 通常、ファイルの名前は cache.dat です。 ドキュメント。

IRIS 2024.3 で発生する2つの製品障害が確認されました。お使いの環境が該当する場合は、それぞれの解決方法にしたがってご対応いただきますよう、よろしくお願いします。

これは、InterSystems FAQサイトの記事です。

質問:

データ容量を見積もる計算式はありますか?

回答:

正確に見積もるための計算式は残念ながらありません。

InterSystems IRIS Data Platformの場合、データ部に関してはデータを全て可変長で格納しますので、各フィールドの平均がどのくらいであるかという目安の数字で平均レコード長を求め、キー部分も同様の計算を行い、必要な容量の推測値を求める必要があります。

インデックス部に関してはキー圧縮されますので、データと同じような上記の計算を行った推測値よりは少なくなることが期待できます。 ただしその圧縮率はデータの特性に大きく影響されますので、どの程度少なくなるかは一概には言えません。

実データのサンプル(例えば、1万件のデータ)をロードし、その時点でのサイズを確認して想定される件数分のデータ容量を推測するというのが現実的な方法となります。

これは InterSystems FAQ サイトの記事です。

永続クラス定義では、データを格納するグローバル変数名を初回クラスコンパイル時に決定しています。

グローバル変数名は、コンパイル後に表示されるストレージ定義(Storage)で確認できます。

例)

開発者の皆さん、こんにちは!

この記事は、2024年7月に開催された「InterSystems Pythonプログラミングコンテスト2024」でエキスパート投票、コミュニティ投票の両方で1位を獲得された @Henry Pereira Pereira さん @José Pereira さん @Henrique Dias Dias さんが開発された sqlzilla について、アプリを動かしてみた感想と、中の構造について @José Pereira さんが投稿された「Text to IRIS with LangChain」の翻訳をご紹介します。

第2回 InterSystems Japan 技術文書ライティングコンテスト 開催! では、生成AIに関連する記事を投稿いただくと、ボーナスポイントを4点獲得できます📢 @José Pereira さんの記事を💡ヒント💡に皆様の操作体験談、アイデアなどを共有いただければと思います。

開発されたアプリSQLzilla についての概要ですが、Open Exchange の sqlzilla のREADMEに以下のように紹介されています。

「SQLzilla は、Python と AI のパワーを活用して、自然言語の SQL クエリ生成を通じてデータ アクセスを簡素化し、複雑なデータ クエリとプログラミング経験の少ないユーザーとの間のギャップを埋めます。」

「SQLクエリ生成」とありますので、アプリには Aviationスキーマ以下3つのテーブルとサンプルデータが用意されています。

3つのテーブルには、米国国家運輸安全委員会に報告された航空事故の選択されたサブセットのデータが含まれています。

メモ: サンプルリポジトリ で提供されるデータセットは、http://www.ntsb.gov から入手できる完全な NTSB データセットの小さなサブセットであるためデモ目的のみで提供されており、正確であることを意図または保証するものではありません。(提供元:National Transportation Safety Board)

例えば、Aviation.Aircraftには、AircraftCategoryカラムがあり、航空機の種別が登録されています。

[SQL]IRISAPP>>SELECT AircraftCategory FROM Aviation.Aircraft GROUP BY AircraftCategory

1. SELECT AircraftCategory FROM Aviation.Aircraft GROUP BY AircraftCategory

| AircraftCategory |

| -- |

| AIRPLANE |

| HELICOPTER |

| GYROCRAFT |

| GLIDER |

| BALLOON |

| POWERED PARACHUTE |

| WEIGHT SHIFT |

また、DepartureCity には、出発都市名が登録されています。

SELECT top 10 DepartureCity FROM Aviation.Aircraft WHERE AircraftCategory='AIRPLANE' GROUP BY DepartureCity

| DepartureCity |

| -- |

| WILBUR |

| IRONWOOD |

| STANIEL CAY |

| OAK ISLAND |

| CLEVELAND |

| DECATUR |

| MARSHALLTOWN |

| MARANA |

| TONOPAH |

| MURRIETA/TEMECU |

また、Aviation.Eventテーブルには発生した事故の情報が含まれていて、InjuriesHighestには負傷者数の状況を文字で表現した情報が含まれています。

SELECT InjuriesHighest FROM Aviation.Event GROUP BY InjuriesHighest

| InjuriesHighest |

| -- |

| NONE |

| FATAL |

| SERIOUS |

| MINOR |

さて、これらのテーブルを使って具体的にどのようなことをしてくれるアプリなのか?ですが(説明文より以下抜粋)

「SQLzilla は、ユーザーがデータベースを操作する方法を変革する革新的なプロジェクトです。InterSystems IRIS と統合することで、SQL に詳しくないユーザーでもさまざまなテーブルからデータを簡単に抽出して分析できるツールを作成しました。」

つまり、

SQLに詳しくないユーザでも、自分の欲しい情報に対して質問するとSQLを組み立てて返してきてくれる便利アプリということになります。

以下、アプリケーションを動作させてみたときの図です。(日本語で質問してもしっかりSQLを組み立ててくれています!)

入力した質問によって生成されたSQLは以下の通りです。

SELECT COUNT(*) FROM Aviation.Aircraft WHERE AircraftCategory = 'Helicopter'

SELECT COUNT(*) FROM Aviation.Event WHERE YEAR(EventDate) = 2002 AND Type = 'Helicopter Accident'

SELECT YEAR(e.EventDate) AS IncidentYear, COUNT(*) AS FatalIncidentCount FROM Aviation.Event e JOIN Aviation.Aircraft a ON e.EventId = a.EventId WHERE a.AircraftCategory = 'Helicopter' AND e.InjuriesHighest = 'FATAL' GROUP BY YEAR(e.EventDate)

アプリ詳細は、ぜひ Open Exchange の sqlzilla をご参照ください。

素晴らしいです!!

※ このサンプルを動作させるためには、OpenAIのAPIキーが必要となりますので、お試しになる場合は事前にご準備ください。

Open Exchange の sqlzilla のREADMEにも記載がありますが、コンテナを使う場合は以下3コマンドでサンプルを動作させることができます。

まずはソースコードをclone して

git clone https://github.com/musketeers-br/sqlzilla.git

コンテナをビルドし

docker-compose build --no-cache --progress=plain

コンテナを開始するだけ

docker-compose up -d

後は、アプリ画面を起動するだけ!

コンテナ以外でも操作する方法が提供されています。詳しくは、 sqlzilla のREADMEご参照ください。(ぜひREADMEの一番下までご覧ください!)

アプリの中でどのようにSQLを生成させているか、については、 @José Pereira さんが投稿された「Text to IRIS with LangChain」の翻訳記事でご紹介します。

LangChainフレームワーク、IRIS Vector Search、LLMを使って、ユーザープロンプトからIRIS互換のSQLを生成する方法についての実験をご紹介します。

この記事は このノートブック を元にしています。 OpenExchange の このアプリケーション を使えば、すぐに使える環境で実行できます。

最初に必要なライブラリをインストールします。

!pip install --upgrade --quiet langchain langchain-openai langchain-iris pandas

次に、必要なモジュールをインポートし、環境をセットアップします。

import os

import datetime

import hashlib

from copy import deepcopy

from sqlalchemy import create_engine

import getpass

import pandas as pd

from langchain_core.prompts import PromptTemplate, ChatPromptTemplate

from langchain_core.example_selectors import SemanticSimilarityExampleSelector

from langchain_openai import OpenAIEmbeddings, ChatOpenAI

from langchain.docstore.document import Document

from langchain_community.document_loaders import DataFrameLoader

from langchain.text_splitter import CharacterTextSplitter

from langchain_core.output_parsers import StrOutputParser

from langchain.globals import set_llm_cache

from langchain.cache import SQLiteCache

from langchain_iris import IRISVector

SQLiteCacheを使ってLLMコールをキャッシュします。

# Cache for LLM calls

set_llm_cache(SQLiteCache(database_path=".langchain.db"))

IRISデータベースへ接続するためのパラメータをセットします。

# IRIS database connection parameters

os.environ["ISC_LOCAL_SQL_HOSTNAME"] = "localhost"

os.environ["ISC_LOCAL_SQL_PORT"] = "1972"

os.environ["ISC_LOCAL_SQL_NAMESPACE"] = "IRISAPP"

os.environ["ISC_LOCAL_SQL_USER"] = "_system"

os.environ["ISC_LOCAL_SQL_PWD"] = "SYS"

OpenAI APIキーが環境変数に設定されていない場合は、ユーザ入力が求められます。

if not "OPENAI_API_KEY" in os.environ:

os.environ["OPENAI_API_KEY"] = getpass.getpass()

IRISデータベースの接続文字列を作成します。

# IRIS database connection string

args = {

'hostname': os.getenv("ISC_LOCAL_SQL_HOSTNAME"),

'port': os.getenv("ISC_LOCAL_SQL_PORT"),

'namespace': os.getenv("ISC_LOCAL_SQL_NAMESPACE"),

'username': os.getenv("ISC_LOCAL_SQL_USER"),

'password': os.getenv("ISC_LOCAL_SQL_PWD")

}

iris_conn_str = f"iris://{args['username']}:{args['password']}@{args['hostname']}:{args['port']}/{args['namespace']}"

IRISデータベースとの接続を確立します。

# Connection to IRIS database

engine = create_engine(iris_conn_str)

cnx = engine.connect().connection

システムプロンプトのコンテキスト情報を保持するdictionaryを用意します。

# Dict for context information for system prompt

context = {}

context["top_k"] = 3

ユーザー入力をIRISデータベースと互換性のあるSQLクエリに変換するために、言語モデル用の効果的なプロンプトを作成する必要があります。

SQLクエリを生成するための基本的な指示を提供する初期プロンプトから始めます。

このテンプレートはLangChain's default prompts for MSSQL から派生し、IRISデータベース用にカスタマイズされています。

# Basic prompt template with IRIS database SQL instructions

iris_sql_template = """

You are an InterSystems IRIS expert. Given an input question, first create a syntactically correct InterSystems IRIS query to run and return the answer to the input question.

Unless the user specifies in the question a specific number of examples to obtain, query for at most {top_k} results using the TOP clause as per InterSystems IRIS. You can order the results to return the most informative data in the database.

Never query for all columns from a table. You must query only the columns that are needed to answer the question. Wrap each column name in single quotes ('') to denote them as delimited identifiers.

Pay attention to use only the column names you can see in the tables below. Be careful to not query for columns that do not exist. Also, pay attention to which column is in which table.

Pay attention to use CAST(CURRENT_DATE as date) function to get the current date, if the question involves "today".

Use double quotes to delimit columns identifiers.

Return just plain SQL; don't apply any kind of formatting.

"""

次のような文章をテンプレートに設定しています: あなたは InterSystems IRIS のエキスパートです。 入力された質問に対して、まず、構文的に正しい InterSystems IRIS クエリを作成し、そのクエリを実行し て、入力された質問に対する回答を返します。 ユーザが質問で特定の数の例を取得するように指定しない限り、InterSystems IRIS に従って、TOP 節を使用して最大 {top_k} の結果をクエリします。 テーブルのすべての列に対してクエリを実行してはなりません。 質問に答えるために必要なカラムのみを問い合わせなければなりません。 各カラム名をシングルクォート('')で囲み、区切り識別子にします。 以下の表で確認できるカラム名のみを使用するように注意してください。 存在しないカラムを問い合わせないように注意してください。 また、どのカラムがどのテーブルにあるかに注意すること。 質問内容が "今日 "を含む場合は、CAST(CURRENT_DATE as date)関数を使用して現在の日付を取得することに注意すること。 カラムの識別子を区切るには二重引用符を使用すること。 単なるSQLを返すこと。いかなるフォーマットも適用しないこと。

この基本プロンプトは、言語モデル(LLM)がIRISデータベースに対する特定のガイダンスを持つSQLエキスパートとして機能するように設定しています。

次に、ハルシネーション(幻覚)を避けるために、データベーススキーマに関する情報を補助プロンプトとして提供します。

# SQL template extension for including tables context information

tables_prompt_template = """

Only use the following tables:

{table_info}

"""

LLMの回答の精度を高めるために、私たちはfew-shot プロンプトと呼ばれるテクニックを使いました。 これはLLMにいくつかの例を提示するものです。

# SQL template extension for including few shots

prompt_sql_few_shots_template = """

Below are a number of examples of questions and their corresponding SQL queries.

{examples_value}

"""

私たちは few-shot の例のためにテンプレートを以下のように定義しています。

# Few shots prompt template

example_prompt_template = "User input: {input}\nSQL query: {query}"

example_prompt = PromptTemplate.from_template(example_prompt_template)

私たちは、 few-shot テンプレートを使ってユーザー・プロンプトを作っています。

# User prompt template

user_prompt = "\n" + example_prompt.invoke({"input": "{input}", "query": ""}).to_string()

最後に、すべてのプロンプトを組み合わせて最終的なプロンプトを作成します。

# Complete prompt template

prompt = (

ChatPromptTemplate.from_messages([("system", iris_sql_template)])

+ ChatPromptTemplate.from_messages([("system", tables_prompt_template)])

+ ChatPromptTemplate.from_messages([("system", prompt_sql_few_shots_template)])

+ ChatPromptTemplate.from_messages([("human", user_prompt)])

)

prompt

このプロンプトは、変数 examples_value, input, table_info, and top_k を想定しています。

プロンプトの構成は以下の通りです。

ChatPromptTemplate(

input_variables=['examples_value', 'input', 'table_info', 'top_k'],

messages=[

SystemMessagePromptTemplate(

prompt=PromptTemplate(

input_variables=['top_k'],

template=iris_sql_template

)

),

SystemMessagePromptTemplate(

prompt=PromptTemplate(

input_variables=['table_info'],

template=tables_prompt_template

)

),

SystemMessagePromptTemplate(

prompt=PromptTemplate(

input_variables=['examples_value'],

template=prompt_sql_few_shots_template

)

),

HumanMessagePromptTemplate(

prompt=PromptTemplate(

input_variables=['input'],

template=user_prompt

)

)

]

)

プロンプトがどのようにLLMに送られるかを視覚化するために、必要な変数にプレースホルダーの値を使うことができます。

prompt_value = prompt.invoke({

"top_k": "<top_k>",

"table_info": "<table_info>",

"examples_value": "<examples_value>",

"input": "<input>"

})

print(prompt_value.to_string())

System:

You are an InterSystems IRIS expert. Given an input question, first create a syntactically correct InterSystems IRIS query to run and return the answer to the input question.

Unless the user specifies in the question a specific number of examples to obtain, query for at most <top_k> results using the TOP clause as per InterSystems IRIS. You can order the results to return the most informative data in the database.

Never query for all columns from a table. You must query only the columns that are needed to answer the question. Wrap each column name in single quotes ('') to denote them as delimited identifiers.

Pay attention to use only the column names you can see in the tables below. Be careful to not query for columns that do not exist. Also, pay attention to which column is in which table.

Pay attention to use CAST(CURRENT_DATE as date) function to get the current date, if the question involves "today".

Use double quotes to delimit columns identifiers.

Return just plain SQL; don't apply any kind of formatting.

System:

Only use the following tables:

<table_info>

System:

Below are a number of examples of questions and their corresponding SQL queries.

<examples_value>

Human:

User input: <input>

SQL query:

これで、必要な変数を与えることで、このプロンプトをLLMに送る準備ができました。 準備ができたら次のステップに進みましょう。

正確なSQLクエリを作成するためには、言語モデル(LLM)にデータベース・テーブルに関する詳細な情報を提供する必要があります。

この情報がないと、LLMは一見もっともらしく見えますが、ハルシネーション(幻覚)により正しくないクエリを生成する可能性があります。 そこで、最初のステップとして、IRISデータベースからテーブル定義を取得する関数を作成します。

以下の関数はINFORMATION_SCHEMAに問い合わせ、指定されたスキーマのテーブル定義を取得します。

特定のテーブルが指定された場合は、そのテーブルの定義を取得します。そうでない場合は、スキーマ内の全てのテーブルの定義を取得します。

def get_table_definitions_array(cnx, schema, table=None):

cursor = cnx.cursor()

# Base query to get columns information

query = """

SELECT TABLE_SCHEMA, TABLE_NAME, COLUMN_NAME, DATA_TYPE, IS_NULLABLE, COLUMN_DEFAULT, PRIMARY_KEY, null EXTRA

FROM INFORMATION_SCHEMA.COLUMNS

WHERE TABLE_SCHEMA = %s

"""

# Parameters for the query

params = [schema]

# Adding optional filters

if table:

query += " AND TABLE_NAME = %s"

params.append(table)

# Execute the query

cursor.execute(query, params)

# Fetch the results

rows = cursor.fetchall()

# Process the results to generate the table definition(s)

table_definitions = {}

for row in rows:

table_schema, table_name, column_name, column_type, is_nullable, column_default, column_key, extra = row

if table_name not in table_definitions:

table_definitions[table_name] = []

table_definitions[table_name].append({

"column_name": column_name,

"column_type": column_type,

"is_nullable": is_nullable,

"column_default": column_default,

"column_key": column_key,

"extra": extra

})

primary_keys = {}

# Build the output string

result = []

for table_name, columns in table_definitions.items():

table_def = f"CREATE TABLE {schema}.{table_name} (\n"

column_definitions = []

for column in columns:

column_def = f" {column['column_name']} {column['column_type']}"

if column['is_nullable'] == "NO":

column_def += " NOT NULL"

if column['column_default'] is not None:

column_def += f" DEFAULT {column['column_default']}"

if column['extra']:

column_def += f" {column['extra']}"

column_definitions.append(column_def)

if table_name in primary_keys:

pk_def = f" PRIMARY KEY ({', '.join(primary_keys[table_name])})"

column_definitions.append(pk_def)

table_def += ",\n".join(column_definitions)

table_def += "\n);"

result.append(table_def)

return result

この例では、Aviationスキーマを使用しています。Aviationスキーマ情報一式については こちら から入手できます。

# Retrieve table definitions for the Aviation schema

tables = get_table_definitions_array(cnx, "Aviation")

print(tables)

この関数は、Aviation スキーマ内のすべてのテーブルの CREATE TABLE ステートメントを返します。

[

'CREATE TABLE Aviation.Aircraft (\n Event bigint NOT NULL,\n ID varchar NOT NULL,\n AccidentExplosion varchar,\n AccidentFire varchar,\n AirFrameHours varchar,\n AirFrameHoursSince varchar,\n AirFrameHoursSinceLastInspection varchar,\n AircraftCategory varchar,\n AircraftCertMaxGrossWeight integer,\n AircraftHomeBuilt varchar,\n AircraftKey integer NOT NULL,\n AircraftManufacturer varchar,\n AircraftModel varchar,\n AircraftRegistrationClass varchar,\n AircraftSerialNo varchar,\n AircraftSeries varchar,\n Damage varchar,\n DepartureAirportId varchar,\n DepartureCity varchar,\n DepartureCountry varchar,\n DepartureSameAsEvent varchar,\n DepartureState varchar,\n DepartureTime integer,\n DepartureTimeZone varchar,\n DestinationAirportId varchar,\n DestinationCity varchar,\n DestinationCountry varchar,\n DestinationSameAsLocal varchar,\n DestinationState varchar,\n EngineCount integer,\n EvacuationOccurred varchar,\n EventId varchar NOT NULL,\n FlightMedical varchar,\n FlightMedicalType varchar,\n FlightPhase integer,\n FlightPlan varchar,\n FlightPlanActivated varchar,\n FlightSiteSeeing varchar,\n FlightType varchar,\n GearType varchar,\n LastInspectionDate timestamp,\n LastInspectionType varchar,\n Missing varchar,\n OperationDomestic varchar,\n OperationScheduled varchar,\n OperationType varchar,\n OperatorCertificate varchar,\n OperatorCertificateNum varchar,\n OperatorCode varchar,\n OperatorCountry varchar,\n OperatorIndividual varchar,\n OperatorName varchar,\n OperatorState varchar,\n Owner varchar,\n OwnerCertified varchar,\n OwnerCountry varchar,\n OwnerState varchar,\n RegistrationNumber varchar,\n ReportedToICAO varchar,\n SeatsCabinCrew integer,\n SeatsFlightCrew integer,\n SeatsPassengers integer,\n SeatsTotal integer,\n SecondPilot varchar,\n childsub bigint NOT NULL DEFAULT $i(^Aviation.EventC("Aircraft"))\n);',

'CREATE TABLE Aviation.Crew (\n Aircraft varchar NOT NULL,\n ID varchar NOT NULL,\n Age integer,\n AircraftKey integer NOT NULL,\n Category varchar,\n CrewNumber integer NOT NULL,\n EventId varchar NOT NULL,\n Injury varchar,\n MedicalCertification varchar,\n MedicalCertificationDate timestamp,\n MedicalCertificationValid varchar,\n Seat varchar,\n SeatbeltUsed varchar,\n Sex varchar,\n ShoulderHarnessUsed varchar,\n ToxicologyTestPerformed varchar,\n childsub bigint NOT NULL DEFAULT $i(^Aviation.AircraftC("Crew"))\n);',

'CREATE TABLE Aviation.Event (\n ID bigint NOT NULL DEFAULT $i(^Aviation.EventD),\n AirportDirection integer,\n AirportDistance varchar,\n AirportElevation integer,\n AirportLocation varchar,\n AirportName varchar,\n Altimeter varchar,\n EventDate timestamp,\n EventId varchar NOT NULL,\n EventTime integer,\n FAADistrictOffice varchar,\n InjuriesGroundFatal integer,\n InjuriesGroundMinor integer,\n InjuriesGroundSerious integer,\n InjuriesHighest varchar,\n InjuriesTotal integer,\n InjuriesTotalFatal integer,\n InjuriesTotalMinor integer,\n InjuriesTotalNone integer,\n InjuriesTotalSerious integer,\n InvestigatingAgency varchar,\n LightConditions varchar,\n LocationCity varchar,\n LocationCoordsLatitude double,\n LocationCoordsLongitude double,\n LocationCountry varchar,\n LocationSiteZipCode varchar,\n LocationState varchar,\n MidAir varchar,\n NTSBId varchar,\n NarrativeCause varchar,\n NarrativeFull varchar,\n NarrativeSummary varchar,\n OnGroundCollision varchar,\n SkyConditionCeiling varchar,\n SkyConditionCeilingHeight integer,\n SkyConditionNonCeiling varchar,\n SkyConditionNonCeilingHeight integer,\n TimeZone varchar,\n Type varchar,\n Visibility varchar,\n WeatherAirTemperature integer,\n WeatherPrecipitation varchar,\n WindDirection integer,\n WindDirectionIndicator varchar,\n WindGust integer,\n WindGustIndicator varchar,\n WindVelocity integer,\n WindVelocityIndicator varchar\n);'

]

これらのテーブル定義ができたので、次のステップに進むことができます。

これにより、LLMがSQLクエリを生成する際に、データベース・スキーマに関する正確で包括的な情報が得られるようになります。

データベース、特に大規模なデータベースを扱う場合、プロンプト内のすべてのテーブルのデータ定義言語(DDL)を送信することは非現実的です。

このアプローチは小規模なデータベースでは有効かもしれませんが、現実のデータベースには数百から数千のテーブルが含まれていることが多く、すべてのテーブルを処理するのは非効率的です。

さらに、SQLクエリを効率的に生成するために、言語モデルがデータベース内のすべてのテーブルを認識する必要があるとは考えにくいです。 この課題に対処するため、セマンティック検索機能を活用し、ユーザーのクエリに基づいて最も関連性の高いテーブルのみを選択することができます。

IRIS Vector Searchでセマンティック検索を使用することでこれを実現します。

この方法は、SQL要素の識別子(テーブル、フィールド、キーなど)に意味のある名前がある場合に最も効果的です。識別子が任意のコードである場合は、代わりにデータ dictionaryの使用を検討してください。

まず、テーブル定義をpandas DataFrameに取り出します。

# Retrieve table definitions into a pandas DataFrame

table_def = get_table_definitions_array(cnx=cnx, schema='Aviation')

table_df = pd.DataFrame(data=table_def, columns=["col_def"])

table_df["id"] = table_df.index + 1

table_df

DataFrame(table_df)は以下のようになります。

| col_def | id | |

|---|---|---|

| 0 | CREATE TABLE Aviation.Aircraft (\n Event bigi... | 1 |

| 1 | CREATE TABLE Aviation.Crew (\n Aircraft varch... | 2 |

| 2 | CREATE TABLE Aviation.Event (\n ID bigint NOT... | 3 |

次に、テーブル定義をLangchain Documentsに分割します。 このステップは、大きなテキストの塊を扱い、テキスト埋め込みを抽出するために非常に重要です。

loader = DataFrameLoader(table_df, page_content_column="col_def")

documents = loader.load()

text_splitter = CharacterTextSplitter(chunk_size=400, chunk_overlap=20, separator="\n")

tables_docs = text_splitter.split_documents(documents)

tables_docs

その結果、tables_docsリストには、次のようにメタデータ付きの分割ドキュメントが含まれます。

[Document(metadata={'id': 1}, page_content='CREATE TABLE Aviation.Aircraft (\n Event bigint NOT NULL,\n ID varchar NOT NULL,\n ...'),

Document(metadata={'id': 2}, page_content='CREATE TABLE Aviation.Crew (\n Aircraft varchar NOT NULL,\n ID varchar NOT NULL,\n ...'),

Document(metadata={'id': 3}, page_content='CREATE TABLE Aviation.Event (\n ID bigint NOT NULL DEFAULT $i(^Aviation.EventD),\n ...')]

次に,langchain-irisのIRISVectorクラスを使って埋め込みベクトルを抽出し、それをIRISに格納します。

tables_vector_store = IRISVector.from_documents(

embedding=OpenAIEmbeddings(),

documents=tables_docs,

connection_string=iris_conn_str,

collection_name="sql_tables",

pre_delete_collection=True

)

注意: pre_delete_collection フラグは、各テスト実行で新鮮なコレクションを確保するために、デモ用に True に設定されています。 本番環境では、このフラグは通常 False に設定します。

テーブルに埋め込み(Embedding)が保存されたことで、ユーザー入力に基づいて関連するテーブルを検索できるようになりました。

input_query = "List the first 2 manufacturers"

relevant_tables_docs = tables_vector_store.similarity_search(input_query, k=3)

relevant_tables_docs

例えば、manufacturers を検索すると、次のような結果が返ってきます。

[Document(metadata={'id': 1}, page_content='GearType varchar,\n LastInspectionDate timestamp,\n ...'),

Document(metadata={'id': 1}, page_content='AircraftModel varchar,\n AircraftRegistrationClass varchar,\n ...'),

Document(metadata={'id': 3}, page_content='LocationSiteZipCode varchar,\n LocationState varchar,\n ...')]

メタデータから、テーブルID 1 (Aviation.Aircraft)だけが関連性があり、クエリと一致していることがわかります。

このアプローチは一般的に効果的ではありますが、常に完璧とは限りません。 たとえば、事故現場のクエリを実行すると、関連性の低いテーブルが返されることもあります。

input_query = "List the top 10 most crash sites"

relevant_tables_docs = tables_vector_store.similarity_search(input_query, k=3)

relevant_tables_docs

結果は以下の通りです。

[Document(metadata={'id': 3}, page_content='LocationSiteZipCode varchar,\n LocationState varchar,\n ...'),

Document(metadata={'id': 3}, page_content='InjuriesGroundSerious integer,\n InjuriesHighest varchar,\n ...'),

Document(metadata={'id': 1}, page_content='CREATE TABLE Aviation.Aircraft (\n Event bigint NOT NULL,\n ID varchar NOT NULL,\n ...')]

正しいAviation.Eventテーブルを2回取得したにもかかわらず、Aviation.Aircraftテーブルも表示されることがあります。これは、この例の範囲を超えているため、将来の実装に委ねられます。

このプロセスを自動化するため、ユーザー入力に基づいて関連するテーブルをフィルタリングして返す関数を定義します。

def get_relevant_tables(user_input, tables_vector_store, table_df):

relevant_tables_docs = tables_vector_store.similarity_search(user_input)

relevant_tables_docs_indices = [x.metadata["id"] for x in relevant_tables_docs]

indices = table_df["id"].isin(relevant_tables_docs_indices)

relevant_tables_array = [x for x in table_df[indices]["col_def"]]

return relevant_tables_array

この機能は、LLMに送信する関連テーブルのみを効率的に検索し、プロンプトの長さを短縮し、クエリ全体のパフォーマンスを向上させるのに役立ちます。

言語モデル(LLM)を扱うとき、適切な例を提供することは、正確で文脈的に適切な応答を保証するのに役立ちます。

これらの例は "Few-Shot" 例と呼ばれ、LLMが処理すべきクエリの構造とコンテキストを理解するためのガイドとなります。今回のケースでは、IRISのSQL構文とデータベースで使用可能なテーブルを幅広くカバーする多様なSQLクエリを examples_value 変数に入力する必要があります。これは、LLMが正しくないクエリーや無関係なクエリーを生成するのを防ぐのに役立ちます。

以下は、様々なSQL操作を説明するために作られたクエリ例のリストです。

examples = [

{"input": "List all aircrafts.", "query": "SELECT * FROM Aviation.Aircraft"},

{"input": "Find all incidents for the aircraft with ID 'N12345'.", "query": "SELECT * FROM Aviation.Event WHERE EventId IN (SELECT EventId FROM Aviation.Aircraft WHERE ID = 'N12345')"},

{"input": "List all incidents in the 'Commercial' operation type.", "query": "SELECT * FROM Aviation.Event WHERE EventId IN (SELECT EventId FROM Aviation.Aircraft WHERE OperationType = 'Commercial')"},

{"input": "Find the total number of incidents.", "query": "SELECT COUNT(*) FROM Aviation.Event"},

{"input": "List all incidents that occurred in 'Canada'.", "query": "SELECT * FROM Aviation.Event WHERE LocationCountry = 'Canada'"},

{"input": "How many incidents are associated with the aircraft with AircraftKey 5?", "query": "SELECT COUNT(*) FROM Aviation.Aircraft WHERE AircraftKey = 5"},

{"input": "Find the total number of distinct aircrafts involved in incidents.", "query": "SELECT COUNT(DISTINCT AircraftKey) FROM Aviation.Aircraft"},

{"input": "List all incidents that occurred after 5 PM.", "query": "SELECT * FROM Aviation.Event WHERE EventTime > 1700"},

{"input": "Who are the top 5 operators by the number of incidents?", "query": "SELECT TOP 5 OperatorName, COUNT(*) AS IncidentCount FROM Aviation.Aircraft GROUP BY OperatorName ORDER BY IncidentCount DESC"},

{"input": "Which incidents occurred in the year 2020?", "query": "SELECT * FROM Aviation.Event WHERE YEAR(EventDate) = '2020'"},

{"input": "What was the month with most events in the year 2020?", "query": "SELECT TOP 1 MONTH(EventDate) EventMonth, COUNT(*) EventCount FROM Aviation.Event WHERE YEAR(EventDate) = '2020' GROUP BY MONTH(EventDate) ORDER BY EventCount DESC"},

{"input": "How many crew members were involved in incidents?", "query": "SELECT COUNT(*) FROM Aviation.Crew"},

{"input": "List all incidents with detailed aircraft information for incidents that occurred in the year 2012.", "query": "SELECT e.EventId, e.EventDate, a.AircraftManufacturer, a.AircraftModel, a.AircraftCategory FROM Aviation.Event e JOIN Aviation.Aircraft a ON e.EventId = a.EventId WHERE Year(e.EventDate) = 2012"},

{"input": "Find all incidents where there were more than 5 injuries and include the aircraft manufacturer and model.", "query": "SELECT e.EventId, e.InjuriesTotal, a.AircraftManufacturer, a.AircraftModel FROM Aviation.Event e JOIN Aviation.Aircraft a ON e.EventId = a.EventId WHERE e.InjuriesTotal > 5"},

{"input": "List all crew members involved in incidents with serious injuries, along with the incident date and location.", "query": "SELECT c.CrewNumber AS 'Crew Number', c.Age, c.Sex AS Gender, e.EventDate AS 'Event Date', e.LocationCity AS 'Location City', e.LocationState AS 'Location State' FROM Aviation.Crew c JOIN Aviation.Event e ON c.EventId = e.EventId WHERE c.Injury = 'Serious'"}

]

例のリストが増え続けることを考えると、LLMにすべての例を提供することは現実的ではありません。代わりに、IRIS Vector SearchとSemanticSimilarityExampleSelectorクラスを使用して、ユーザーのプロンプトに基づいて最も関連性の高い例を特定します。

example_selector = SemanticSimilarityExampleSelector.from_examples(

examples,

OpenAIEmbeddings(),

IRISVector,

k=5,

input_keys=["input"],

connection_string=iris_conn_str,

collection_name="sql_samples",

pre_delete_collection=True

)

注意: pre_delete_collection フラグは、各テスト実行で新鮮なコレクションを確保するためのデモンストレーション目的で使用されています。本番環境では、不要な削除を避けるためにこのフラグを False に設定する必要があります。

与えられた入力に最も関連する例を見つけるには、次のようにSelector を使用します。

input_query = "Find all events in 2010 informing the Event Id and date, location city and state, aircraft manufacturer and model."

relevant_examples = example_selector.select_examples({"input": input_query})

結果は以下のようになります。

[{'input': 'List all incidents with detailed aircraft information for incidents that occurred in the year 2012.', 'query': 'SELECT e.EventId, e.EventDate, a.AircraftManufacturer, a.AircraftModel, a.AircraftCategory FROM Aviation.Event e JOIN Aviation.Aircraft a ON e.EventId = a.EventId WHERE Year(e.EventDate) = 2012'},

{'input': "Find all incidents for the aircraft with ID 'N12345'.", 'query': "SELECT * FROM Aviation.Event WHERE EventId IN (SELECT EventId FROM Aviation.Aircraft WHERE ID = 'N12345')"},

{'input': 'Find all incidents where there were more than 5 injuries and include the aircraft manufacturer and model.', 'query': 'SELECT e.EventId, e.InjuriesTotal, a.AircraftManufacturer, a.AircraftModel FROM Aviation.Event e JOIN Aviation.Aircraft a ON e.EventId = a.EventId WHERE e.InjuriesTotal > 5'},

{'input': 'List all aircrafts.', 'query': 'SELECT * FROM Aviation.Aircraft'},

{'input': 'Find the total number of distinct aircrafts involved in incidents.', 'query': 'SELECT COUNT(DISTINCT AircraftKey) FROM Aviation.Aircraft'}]

数量に関連した例が特に必要な場合は、それに応じてSelectorに問い合わせることができます。

input_query = "What is the number of incidents involving Boeing aircraft."

quantity_examples = example_selector.select_examples({"input": input_query})

出力は以下の通りです。

[{'input': 'How many incidents are associated with the aircraft with AircraftKey 5?', 'query': 'SELECT COUNT(*) FROM Aviation.Aircraft WHERE AircraftKey = 5'},

{'input': 'Find the total number of distinct aircrafts involved in incidents.', 'query': 'SELECT COUNT(DISTINCT AircraftKey) FROM Aviation.Aircraft'},

{'input': 'How many crew members were involved in incidents?', 'query': 'SELECT COUNT(*) FROM Aviation.Crew'},

{'input': 'Find all incidents where there were more than 5 injuries and include the aircraft manufacturer and model.', 'query': 'SELECT e.EventId, e.InjuriesTotal, a.AircraftManufacturer, a.AircraftModel FROM Aviation.Event e JOIN Aviation.Aircraft a ON e.EventId = a.EventId WHERE e.InjuriesTotal > 5'},

{'input': 'List all incidents with detailed aircraft information for incidents that occurred in the year 2012.', 'query': 'SELECT e.EventId, e.EventDate, a.AircraftManufacturer, a.AircraftModel, a.AircraftCategory FROM Aviation.Event e JOIN Aviation.Aircraft a ON e.EventId = a.EventId WHERE Year(e.EventDate) = 2012'}]

この出力には、特にカウントと量を扱った例が含まれています。

SemanticSimilarityExampleSelectorは強力ですが、選択された例がすべて完璧であるとは限らないことに注意することが重要です。

将来的な改良には、フィルターやしきい値を追加して関連性の低い結果を除外し、最も適切な例だけがLLMに提供されるようにすることが含まれるかもしれません。

プロンプトとSQLクエリ生成のパフォーマンスを評価するために、一連のテストを設定し実行する必要があります。その目的は、LLMがユーザーの入力に基づいてSQLクエリを生成する際に、例題に基づいたfew shotを使用する場合と使用しない場合の、その精度を評価することである。

まず、LLMを使って、提供されたコンテキスト、プロンプト、ユーザー入力、その他のパラメーターに基づいてSQLクエリーを生成する関数を定義します。

def get_sql_from_text(context, prompt, user_input, use_few_shots, tables_vector_store, table_df, example_selector=None, example_prompt=None):

relevant_tables = get_relevant_tables(user_input, tables_vector_store, table_df)

context["table_info"] = "\n\n".join(relevant_tables)

examples = example_selector.select_examples({"input": user_input}) if example_selector else []

context["examples_value"] = "\n\n".join([

example_prompt.invoke(x).to_string() for x in examples

])

model = ChatOpenAI(model="gpt-3.5-turbo", temperature=0)

output_parser = StrOutputParser()

chain_model = prompt | model | output_parser

response = chain_model.invoke({

"top_k": context["top_k"],

"table_info": context["table_info"],

"examples_value": context["examples_value"],

"input": user_input

})

return response

例文がある場合とない場合のプロンプトをテストします。

# Prompt execution **with** few shots

input = "Find all events in 2010 informing the Event Id and date, location city and state, aircraft manufacturer and model."

response_with_few_shots = get_sql_from_text(

context,

prompt,

user_input=input,

use_few_shots=True,

tables_vector_store=tables_vector_store,

table_df=table_df,

example_selector=example_selector,

example_prompt=example_prompt,

)

print(response_with_few_shots)

SELECT e.EventId, e.EventDate, e.LocationCity, e.LocationState, a.AircraftManufacturer, a.AircraftModel

FROM Aviation.Event e

JOIN Aviation.Aircraft a ON e.EventId = a.EventId

WHERE Year(e.EventDate) = 2010

# Prompt execution **without** few shots

input = "Find all events in 2010 informing the Event Id and date, location city and state, aircraft manufacturer and model."

response_with_no_few_shots = get_sql_from_text(

context,

prompt,

user_input=input,

use_few_shots=False,

tables_vector_store=tables_vector_store,

table_df=table_df,

)

print(response_with_no_few_shots)

SELECT TOP 3 "EventId", "EventDate", "LocationCity", "LocationState", "AircraftManufacturer", "AircraftModel"

FROM Aviation.Event e

JOIN Aviation.Aircraft a ON e.ID = a.Event

WHERE e.EventDate >= '2010-01-01' AND e.EventDate < '2011-01-01'

Utility Functions for Testing

生成されたSQLクエリをテストするために、いくつかのユーティリティ関数を定義します。

def execute_sql_query(cnx, query):

try:

cursor = cnx.cursor()

cursor.execute(query)

rows = cursor.fetchall()

return rows

except:

print('Error running query:')

print(query)

print('-'*80)

return None

def sql_result_equals(cnx, query, expected):

rows = execute_sql_query(cnx, query)

result = [set(row._asdict().values()) for row in rows or []]

if result != expected and rows is not None:

print('Result not as expected for query:')

print(query)

print('-'*80)

return result == expected

# SQL test for prompt **with** few shots

print("SQL is OK" if not execute_sql_query(cnx, response_with_few_shots) is None else "SQL is not OK")

SQL is OK

# SQL test for prompt **without** few shots

print("SQL is OK" if not execute_sql_query(cnx, response_with_no_few_shots) is None else "SQL is not OK")

error on running query:

SELECT TOP 3 "EventId", "EventDate", "LocationCity", "LocationState", "AircraftManufacturer", "AircraftModel"

FROM Aviation.Event e

JOIN Aviation.Aircraft a ON e.ID = a.Event

WHERE e.EventDate >= '2010-01-01' AND e.EventDate < '2011-01-01'

--------------------------------------------------------------------------------

SQL is not OK

一連のテストケースを定義し、実行します。

tests = [{

"input": "What were the top 3 years with the most recorded events?",

"expected": [{128, 2003}, {122, 2007}, {117, 2005}]

},{

"input": "How many incidents involving Boeing aircraft.",

"expected": [{5}]

},{

"input": "How many incidents that resulted in fatalities.",

"expected": [{237}]

},{

"input": "List event Id and date and, crew number, age and gender for incidents that occurred in 2013.",

"expected": [{1, datetime.datetime(2013, 3, 4, 11, 6), '20130305X71252', 59, 'M'},

{1, datetime.datetime(2013, 1, 1, 15, 0), '20130101X94035', 32, 'M'},

{2, datetime.datetime(2013, 1, 1, 15, 0), '20130101X94035', 35, 'M'},

{1, datetime.datetime(2013, 1, 12, 15, 0), '20130113X42535', 25, 'M'},

{2, datetime.datetime(2013, 1, 12, 15, 0), '20130113X42535', 34, 'M'},

{1, datetime.datetime(2013, 2, 1, 15, 0), '20130203X53401', 29, 'M'},

{1, datetime.datetime(2013, 2, 15, 15, 0), '20130218X70747', 27, 'M'},

{1, datetime.datetime(2013, 3, 2, 15, 0), '20130303X21011', 49, 'M'},

{1, datetime.datetime(2013, 3, 23, 13, 52), '20130326X85150', 'M', None}]

},{

"input": "Find the total number of incidents that occurred in the United States.",

"expected": [{1178}]

},{

"input": "List all incidents latitude and longitude coordinates with more than 5 injuries that occurred in 2010.",

"expected": [{-78.76833333333333, 43.25277777777778}]

},{

"input": "Find all incidents in 2010 informing the Event Id and date, location city and state, aircraft manufacturer and model.",

"expected": [

{datetime.datetime(2010, 5, 20, 13, 43), '20100520X60222', 'CIRRUS DESIGN CORP', 'Farmingdale', 'New York', 'SR22'},

{datetime.datetime(2010, 4, 11, 15, 0), '20100411X73253', 'CZECH AIRCRAFT WORKS SPOL SRO', 'Millbrook', 'New York', 'SPORTCRUISER'},

{'108', datetime.datetime(2010, 1, 9, 12, 55), '20100111X41106', 'Bayport', 'New York', 'STINSON'},

{datetime.datetime(2010, 8, 1, 14, 20), '20100801X85218', 'A185F', 'CESSNA', 'New York', 'Newfane'}

]

}]

テストを実施し、精度を計算します。

def execute_tests(cnx, context, prompt, use_few_shots, tables_vector_store, table_df, example_selector, example_prompt):

tests_generated_sql = [(x, get_sql_from_text(

context,

prompt,

user_input=x['input'],

use_few_shots=use_few_shots,

tables_vector_store=tables_vector_store,

table_df=table_df,

example_selector=example_selector if use_few_shots else None,

example_prompt=example_prompt if use_few_shots else None,

)) for x in deepcopy(tests)]

tests_sql_executions = [(x[0], sql_result_equals(cnx, x[1], x[0]['expected']))

for x in tests_generated_sql]

accuracy = sum(1 for i in tests_sql_executions if i[1] == True) / len(tests_sql_executions)

print(f'Accuracy: {accuracy}')

print('-'*80)

# Accuracy tests for prompts executed **without** few shots

use_few_shots = False

execute_tests(

cnx,

context,

prompt,

use_few_shots,

tables_vector_store,

table_df,

example_selector,

example_prompt

)

error on running query:

SELECT "EventDate", COUNT("EventId") as "TotalEvents"

FROM Aviation.Event

GROUP BY "EventDate"

ORDER BY "TotalEvents" DESC

TOP 3;

--------------------------------------------------------------------------------

error on running query:

SELECT "EventId", "EventDate", "C"."CrewNumber", "C"."Age", "C"."Sex"

FROM "Aviation.Event" AS "E"

JOIN "Aviation.Crew" AS "C" ON "E"."ID" = "C"."EventId"

WHERE "E"."EventDate" >= '2013-01-01' AND "E"."EventDate" < '2014-01-01'

--------------------------------------------------------------------------------

result not expected for query:

SELECT TOP 3 "e"."EventId", "e"."EventDate", "e"."LocationCity", "e"."LocationState", "a"."AircraftManufacturer", "a"."AircraftModel"

FROM "Aviation"."Event" AS "e"

JOIN "Aviation"."Aircraft" AS "a" ON "e"."ID" = "a"."Event"

WHERE "e"."EventDate" >= '2010-01-01' AND "e"."EventDate" < '2011-01-01'

--------------------------------------------------------------------------------

accuracy: 0.5714285714285714

--------------------------------------------------------------------------------

# Accuracy tests for prompts executed **with** few shots

use_few_shots = True

execute_tests(

cnx,

context,

prompt,

use_few_shots,

tables_vector_store,

table_df,

example_selector,

example_prompt

)

error on running query:

SELECT e.EventId, e.EventDate, e.LocationCity, e.LocationState, a.AircraftManufacturer, a.AircraftModel

FROM Aviation.Event e

JOIN Aviation.Aircraft a ON e.EventId = a.EventId

WHERE Year(e.EventDate) = 2010 TOP 3

--------------------------------------------------------------------------------

accuracy: 0.8571428571428571

--------------------------------------------------------------------------------

例(few shots)を使って生成されたSQLクエリの精度は、例なしで生成されたもの(85%対57%)に比べて約49%高くなりました。

Debeziumをご存じでしょうか?

グローバルサミット2023にて、Debeziumを題材としたセッション「Near Real Time Analytics with InterSystems IRIS & Debezium Change Data Capture」がありましたので、ご覧になられた方もおられるかと思います。

ご興味がありましたら、グローバルサミット2023の録画アーカイブをご覧ください。

FAQによると、"dee-BEE-zee-uhm"(ディビジウム..ですかね)と読むそうです。元素周期表のように複数のDB(s)を束ねる、というニュアンスみたいです。

CDC(Change data capture)という分野のソフトウェアです。

外部データベースでの変更を追跡して、IRISに反映したいという要望は、インターオペラビリティ機能導入の動機のひとつになっています。一般的には、定期的にSELECT文のポーリングをおこなって、変更対象となるレコード群(差分。対象が少なければ全件)を外部システムから取得する方法が、お手軽で汎用性も高いですが、タイムスタンプや更新の都度に増加するようなバージョンフィールドが元テーブルに存在しない場合、どうしても、各ポーリング間で重複や見落としがでないように、受信側で工夫する必要があります。また、この方法ではデータの削除を反映することはできませんので、代替案として削除フラグを採用するといったアプリケーションでの対応が必要になります。

CDCは、DBMSのトランザクションログをキャプチャすることで、この課題への解決策を提供しています。DebeziumはRedHatが中心となっているCDCのオープンソースプロジェクトです。

CDCにはいくつかの利点があります。

ポーリングではないので、更新が瞬時に伝わる

DELETEも反映できる

SourceになるDBMSに対して非侵襲的

テーブル定義を変更したり専用のテーブルを作成しなくて済む。パフォーマンスへの影響が軽微。

先進医療っぽい表現ですね。対象に与える影響が軽微というニュアンスだと思います。

受信側(アプリケーション側)の設計が楽

下記は受信側の仕組みに依存する話ですが、例えばIRISのRESTサービスで受信する場合

ひとつのハンドラ(Restのディスパッチクラス)で、複数のテーブルを処理できる

このことはSQLインバウンドサービスがテーブル単位であることと対照的です。

一方、トランザクションログのメカニズムは各DBMS固有なので、DBMSやそのバージョン毎にセットアップ手順、振る舞い、特性が異なる可能性があるというマイナス面があります。

セットアップ作業は、SQLインバウンドアダプタほど簡単ではありません。

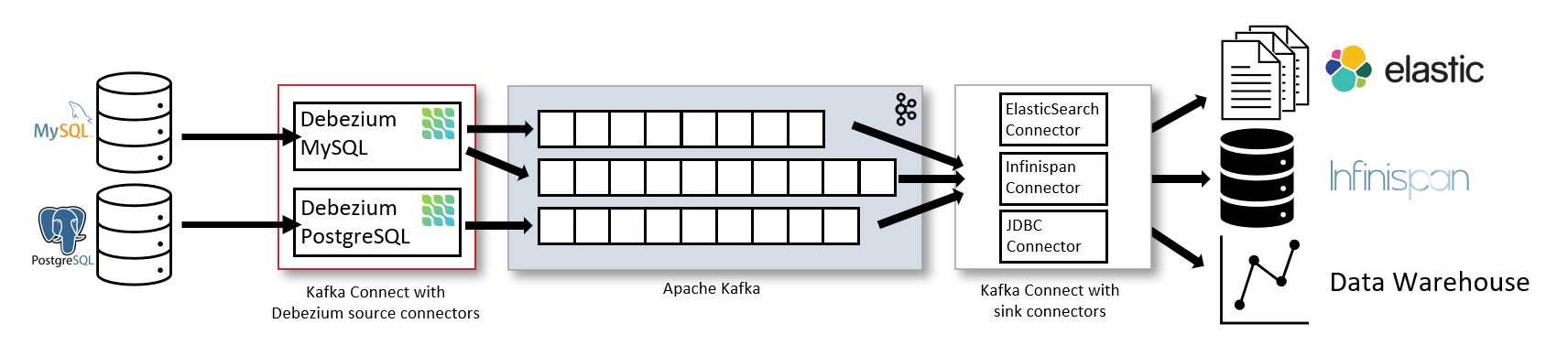

DebeziumはKafkaのSourceコネクタとして使用する用法が一般的です。

引用元: https://debezium.io/documentation/reference/stable/architecture.html

Kafkaのコネクタとしての用法は本稿では扱いません。

今回のメインテーマはKafkaではありませんが、関連するいくつかのKafka用語を確認をしておきたいと思います。

Kakfaにメッセージを送信するデータの発生元のことをProducer、メッセージを消費する送信先のことをConsumerと呼びます。

外部システムとの連携用のフレームワークをKafkaコネクトと呼びます。Kafkaコネクトにおいて、外部システムと接続する部分をコネクタと呼び、Producer 側の コネクタ は Sourceコネクタ、Consumer 側の コネクタ は Sinkコネクタと、それぞれ呼びます。

DebeziumはKafkaのSourceコネクタです。

Kafkaが提供するエンタープライズ級の機能を使いたければ、Kafkaの構成・運用を含めて検討する価値があります。一方、そうでない場合、Debeziumを単体のサーバで動作させることが出来ます。

Debezium Serverと言います。その他の選択肢として、自作のJavaアプリケーションに組み込む方法もあります。

随分とシンプルな構成になります。

KafkaのSinkコネクタを経由しなくても、Debezium自身が様々な送信先に対応しています。Debeziumから見ると、Kafkaは送信先のひとつという位置づけです。

例えば、「POSTGRES上でのデータ更新をCDCして、その内容をhttp serverに送信」したい場合、 POSTGRES用のSourceコネクタと、http Clientを使うことになります。

Debeziumは、SourceとしてこれらのDBMSに対応しています。

残念ながらIRISはSourceになれません。IRISからIRISへのデータの同期であれば非同期ミラリングがお勧めです。

今回使用するソースコード一式はこちらにあります。 IRIS環境はコミュニティエディションにネームスペースMYAPPの作成と、3個の空のテーブル作成(01_createtable.sqlを使用)を行ったものになります。

$ git clone https://github.com/IRISMeister/DebeziumServer-IRIS

$ cd DebeziumServer-IRIS

$ cd postgres (POSTGRESを試す場合。以降POSTGRESを使用します)

あるいは

$ cd mysql (MYSQLを試す場合)

$ ./up.sh

正常に起動した場合、3個のサービスが稼働中になります。

$ docker composeps ps

NAME IMAGE COMMAND SERVICE CREATED STATUS PORTS

iris postgres-iris "/tini -- /iris-main --ISCAgent false --monitorCPF false" iris 12 minutes ago Up 12 minutes (healthy) 2188/tcp, 53773/tcp, 0.0.0.0:1972->1972/tcp, :::1972->1972/tcp, 54773/tcp, 0.0.0.0:52873->52773/tcp, :::52873->52773/tcp

postgres-debezium-server-1 debezium/server:2.4 "/debezium/run.sh" debezium-server 12 minutes ago Up 12 minutes 8080/tcp, 8443/tcp, 8778/tcp

postgres-postgres-1 debezium/example-postgres "docker-entrypoint.sh postgres" postgres 12 minutes ago Up 12 minutes 0.0.0.0:5432->5432/tcp, :::5432->5432/tcp

初期状態を確認します。起動直後に、POSTGRES上の既存のレコード群がIRISに送信されますのでそれを確認します。端末を2個ひらいておくと便利です。以下(端末1)をPOSTGRESの, (端末2)をIRISのSQL実行に使用します。

(端末1 PG)

$ docker compose exec -u postgres postgres psql

psql (15.2 (Debian 15.2-1.pgdg110+1))

Type "help" for help.

postgres=# select * from inventory.orders;

id | order_date | purchaser | quantity | product_id

-------+------------+-----------+----------+------------

10001 | 2016-01-16 | 1001 | 1 | 102

10002 | 2016-01-17 | 1002 | 2 | 105

10003 | 2016-02-19 | 1002 | 2 | 106

10004 | 2016-02-21 | 1003 | 1 | 107

(4 rows)

postgres=# select * from inventory.products;

id | name | description | weight

-----+--------------------+---------------------------------------------------------+--------

101 | scooter | Small 2-wheel scooter | 3.14

102 | car battery | 12V car battery | 8.1

103 | 12-pack drill bits | 12-pack of drill bits with sizes ranging from #40 to #3 | 0.8

104 | hammer | 12oz carpenter's hammer | 0.75

105 | hammer | 14oz carpenter's hammer | 0.875

106 | hammer | 16oz carpenter's hammer | 1

107 | rocks | box of assorted rocks | 5.3

108 | jacket | water resistent black wind breaker | 0.1

109 | spare tire | 24 inch spare tire | 22.2

(9 rows)

postgres=# select * from inventory.customers;

id | first_name | last_name | email

------+------------+-----------+-----------------------

1001 | Sally | Thomas | sally.thomas@acme.com

1002 | George | Bailey | gbailey@foobar.com

1003 | Edward | Walker | ed@walker.com

1004 | Anne | Kretchmar | annek@noanswer.org

(4 rows)

postgres=# \q

$

IRIS上のレコードは下記のコマンドで確認できます。POSTGRES上のレコードと同じになっているはずです。

(端末2 IRIS)

$ docker compose exec iris iris sql iris -Umyapp

[SQL]MYAPP>>set selectmode=odbc

[SQL]MYAPP>>select * from inventory.orders

出力は省略

[SQL]MYAPP>>select * from inventory.products

[SQL]MYAPP>>select * from inventory.customers

次に、POSTGRESで各種DMLを実行します。

(端末1 PG)

update inventory.orders set quantity=200 where id=10001;

UPDATE 1

postgres=# delete from inventory.orders where id=10002;

DELETE 1

insert into inventory.orders (order_date,purchaser,quantity,product_id) values ('2023-01-01',1003,10,105);

INSERT 0 1

update inventory.products set description='商品説明' where id=101;

UPDATE 1

その結果がIRISに伝わり反映されます。

(端末2 IRIS)

[SQL]MYAPP>>select * from inventory.orders

3. select * from inventory.orders

id order_date purchaser quantity product_id

10001 2016-01-16 1001 300 102

10003 2016-02-19 1002 2 106

10004 2016-02-21 1003 1 107

10005 2023-01-01 1003 10 105

4 Rows(s) Affected

[SQL]MYAPP>>select * from inventory.products where id=101

4. select * from inventory.products where id=101

id name description weight

101 scooter 商品説明 3.14

1 Rows(s) Affected

Debezium Serverのhttp clientは、指定したエンドポイントにREST+JSON形式で内容を送信してくれます。エンドポイントにIRISのRESTサービスを指定することで、IRISでその内容をパースし、必要な処理を実行(今回は単純にSQLの実行)しています。

INSERT時には、こちら、UPDATE時には、こちらのようなJSONがPOSTされます。

payload.opにPOSTGRESへの操作の値であるc:Create, u:Update, d:Delete, r:Readが伝わりますので、その内容に基づいて、IRISのRESTディスパッチャークラス(Dispatcher.cls)にて、SQL文を組み立てて実行しています。

r:Readは、初回接続時に実行されるスナップショット取得作業の際に既存のレコード群を読み込み(READ)、それらが送信される場合に使用されます。詳細はこちらをご覧ください。

Debezium Serverの詳細は公式ドキュメントをご覧ください。

ドキュメントを見ると大量のコーディング例(Java)と構成例が載っており、これ全部理解してプログラムを書かないと使えないのかと思ってしまいますが、幸いコンテナイメージとして公開されていますので、今回はそれを利用しています。ソースコードも公開されています。

明言はされていませんでしたが、グローバルサミット2023のデモは、JavaベースのカスタムアプリケーションサーバからJava APIを使用してDebeziumの機能を使用するスタイルかもしれません

Debezium Serverの欠点といいますか特徴として、接続先が未達になると直ぐ落ちるというのがあります。例えばIRISが停止すると、Debezium Serverが停止(今回の構成では、コンテナが停止)してしまいます。ただ、どこまで処理したかをO/Sファイル(本例ではdata/offsets.dat)に保存していますので、IRIS起動後に、Debezium Serverのコンテナを再開すれば、停止中に発生した更新をキャプチャしてくれます。

停止したコンテナの再開は下記コマンドで行います。

docker compose start debezium-server

「あれ、落ちるんだ」と思いましたが、フェールセーフ思想なのだと思います。 対障害性はKafka Connectに管理してもらう前提になっているためだと思います。

MYSQLもほぼ同じ操作で動作確認が出来ます。./mysqlに必要なファイルがあります。mysql.txtを参照ください。

また、今回は、レコードを同期しているだけですが、GS2023のように組み込みBIのキューブを作成して分析用途にしたり、何某かのビジネスロジックを実行したり、インターオペラビリティ機能に連動させたりといった応用が考えられます。

これは InterSystems FAQ サイトの記事です。

以下の状態の時、ReadOnlyでマウントされます。

これは InterSystems FAQ サイトの記事です。

バージョン2017.2以降から、CREATE TABLE文で作成したテーブル定義のデータを格納するグローバル変数の命名ルールが変わり ^EPgS.D8T6.1 のようなハッシュ化したグローバル変数名が設定されます。(この変更はパフォーマンス向上のために追加されました。)

※ バージョン2017.1以前については、永続クラス定義のルールと同一です。詳細は関連記事「永続クラス定義のデータが格納されるグローバル変数名について」をご参照ください。

以下のテーブル定義を作成すると、同名の永続クラス定義が作成されます。

CREATETABLE Test.Product(

ProductID VARCHAR(10) PRIMARY KEY,

ProductName VARCHAR(50),

Price INTEGER

)永続クラス:Test.Productの定義は以下の通りです。(パラメータ:USEEXTENTSETに1が設定されます)

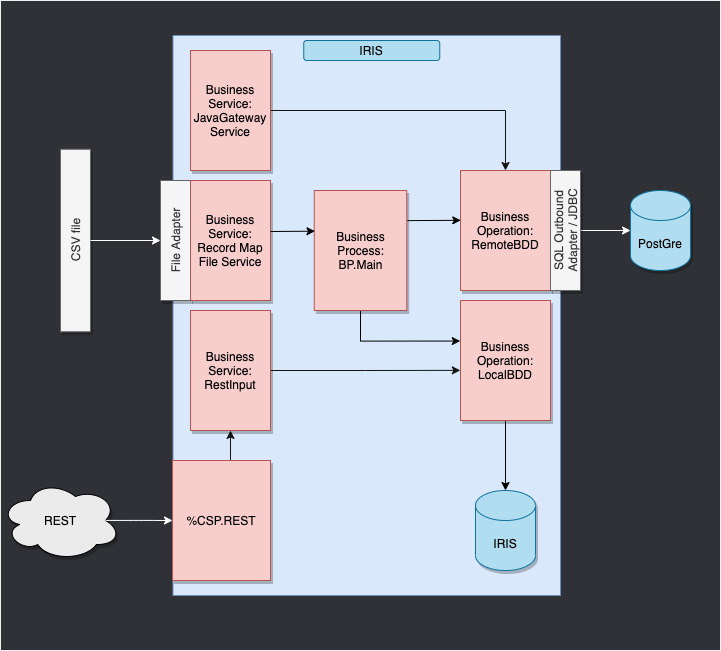

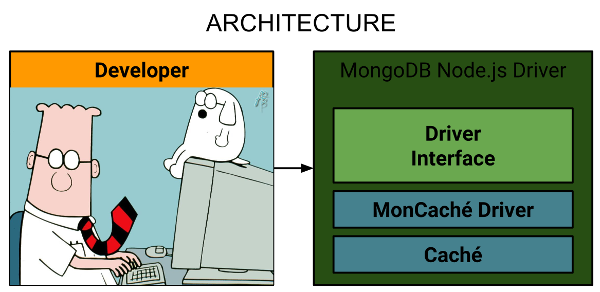

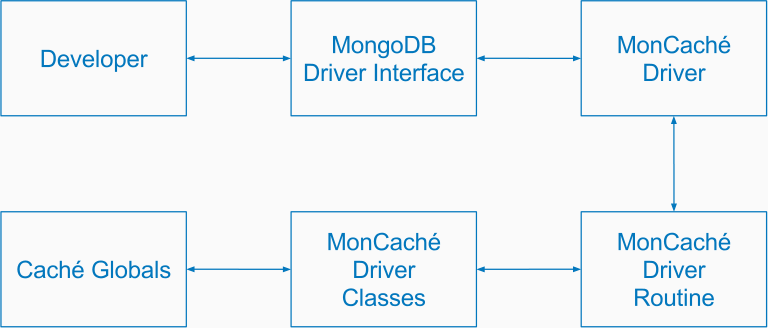

このフォーメーションは私の GitHub にあり、30 分で csv ファイルと txt ファイルの読み取りと書き込み方法、Postgres を使ったIRIS データベースとリモートデータベースの挿入とアクセス方法、FLASK API の使用方法について説明します。これらすべてに、PEP8 命名規則に従った、Python のみのインターオペラビリティフレームワークを使用します。

このフォーメーションは、ほとんどをコピー&ペースト操作で実行でき、グローバル演習を行う前に、ステップごとの操作が説明されています。

記事のコメント欄、Teams、またはメール(lucas.enard@intersystems.com)でご質問にお答えします。

このフォーメーションに関するあらゆる点において、ご意見やご感想をお送りいただけると幸いです。

このフォーメーションでは、Python および特に以下を使用した InterSystems のインターオペラビリティフレームワークを学習することを目標としています。

目次:

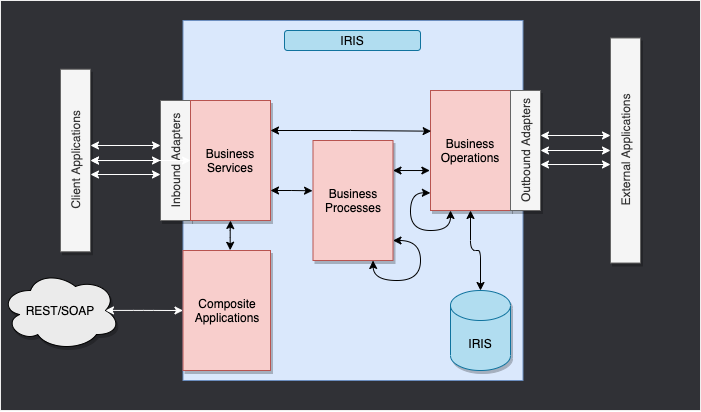

以下は、IRIS フレームワークです。

IRIS 内部のコンポーネントは、本番環境を表します。 インバウンドアダプターとアウトバウンドアダプターは、様々な種類のフォーマットをデータベースの入力と出力として使用できるようにします。

複合アプリケーションにより、REST サービスなどの外部アプリケーションを通じて本番環境にアクセスできます。

これらのコンポーネントを繋ぐ矢印はメッセージで、 リクエストかレスポンスを表します。

ここでは、CSV ファイルから行を読み取り、IRIS データベースに .txt ファイルで保存します。

次に、外部データベースにオブジェクトを保存できるようにするオペレーションを db-api を使って追加します。 このデータベースは Docker コンテナに配置されており、Postgres を使用します。

最後に、複合アプリケーションを使用して、新しいオブジェクトをデータベースに挿入する方法またはこのデータベースを照会する方法を確認します(ここでは、REST サービスを使用します)。

この目的に合わせて構成されたフレームワークは、以下のようになります。

WIP

このフォーメーションでは、以下の項目が必要です。

InterSystems イメージにアクセスするために、次の URL に移動してください: http://container.intersystems.com。 InterSystems の資格情報にリンクすると、レジストリに接続するためのパスワードを取得できます。 Docker の VSCode アドオンのイメージタブで、[レジストリを接続]を押し、汎用レジストリとして上記の URL(http://container.intersystems.com)を入力すると、資格情報の入力を求められます。 このログインは通常のログインですが、パスワードはウェブサイトから取得したものを使用します。

これが済むと、コンテナを構築・作成(指定された docker-compose.yml と Dockerfile を使用)できるようになります。

このリポジトリは、VS Code 対応です。

ローカルにクローンした formation-template-python を VS Code で開きます。

指示されたら(右下に表示)、推奨される拡張機能をインストールしてください。

コーディングする前に、コンテナ内部にアクセスしていることが非常に重要です。

これには、docker が VSCode を開く前に有効である必要があります。

次に VSCode 内で指示されたら(右下に表示)、コンテナ内のフォルダを開き直すと、その中にある Python コンポーネントを使用できるようになります。

これを初めて行う場合、コンテナの準備が整うまで数分かかる場合があります。

リモートのフォルダを開くと、その中で開く VS Code とターミナルで、コンテナ内の Python コンポーネントを使用できます。 /usr/irissys/bin/irispython を使用するように構成してください。

本番環境に対して Python で作成しているコンポーネントを登録するには、grongier.pex._utils モジュールから register_component 関数を使用する必要があります。

重要: コンポーネントはすでに登録済みです(グローバル演習を除く)。

情報までに、またグローバル演習で使用できるように、以下の手順でコンポーネントを登録します。

これには、プロジェクトで作業している際に、最初に組み込み Python コンソールを使用して手動でコンポーネントを追加することをお勧めします。

これらのコマンドは、misc/register.py ファイルにあります。

このコマンドを使用するには、まずコンポーネントを作成してから、VSCode でターミナルを起動する必要があります(5.2 と 5.3 の手順を実行している場合は、自動的にコンテナ内に移動しています)。

IrisPython コンソールを起動するには、以下のように入力します。

/usr/irissys/bin/irispython

次に、以下を入力します。

from grongier.pex._utils import register_component

そして、以下のようにして、コンポーネントを登録できます。

register_component("bo","FileOperation","/irisdev/app/src/python/",1,"Python.FileOperation")

この行は、bo モジュール内にコーディングされている FileOperation クラスを登録します。このファイルは /irisdev/app/src/python/(このコースに従って作業している場合のパス)にあり、管理ポータルでは Python.FileOperation という名前を使用しています。

コンポーネントが登録済みである際にこのファイルの名前、クラスまたはパスを変更しない場合、VSCode でそれらを変更することが可能です。登録し直す必要はありません。 管理ポータルでの再起動は、必ず行ってください。

フォーメーションのある時点でやり方がわからなくなったり、さらに説明が必要となった場合は、GitHub の solution ブランチにすべての正しい内容と動作する本番環境をご覧いただけます。

本番環境は、Iris 上のすべての作業の土台であり、サービス、プロセス、およびオペレーションをまとめるフレームワークの外殻として考える必要があります。

本番環境内のすべては関数を継承します。この関数は、このクラスのインスタンスの作成時に解決する on_init 関数と、インスタンスがキルされたときに解決する on_tear_down 関数です。 これは、書き込みを行うときに変数を設定する際、または使用された開いているファイルをクローンする際に役立ちます。

ほぼすべてのサービス、プロセス、およびオペレーションを持つ本番環境は、すでに作成済みであることに注意してください。

指示されたら、ユーザー名の SuperUser とパスワードの SYS を使用して接続してください。

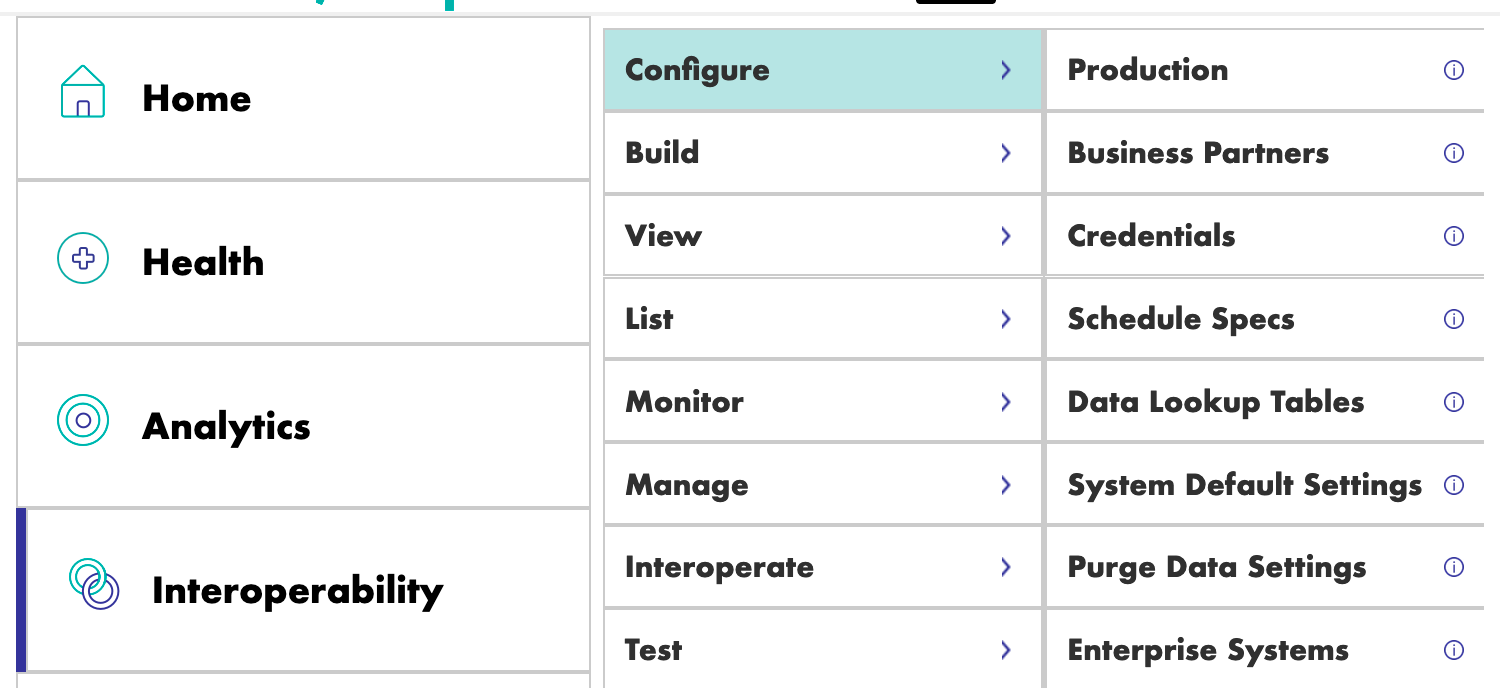

本番環境が開いていない場合は、[Interoperability] > [Configure] メニューに移動して、[Production] をクリックし、 次に [Open] をクリックして iris / Production を選択します。

これを行ったら、ビジネスオペレーションに直接進むことができます。

ただし、本番環境の作成方法に興味がある場合は、以下のようにして作成することができます。

管理ポータルに移動し、ユーザー名: SuperUser、パスワード: SYS を使用して接続します。

次に、[Interoperability] と [Configure] メニューに進みます。

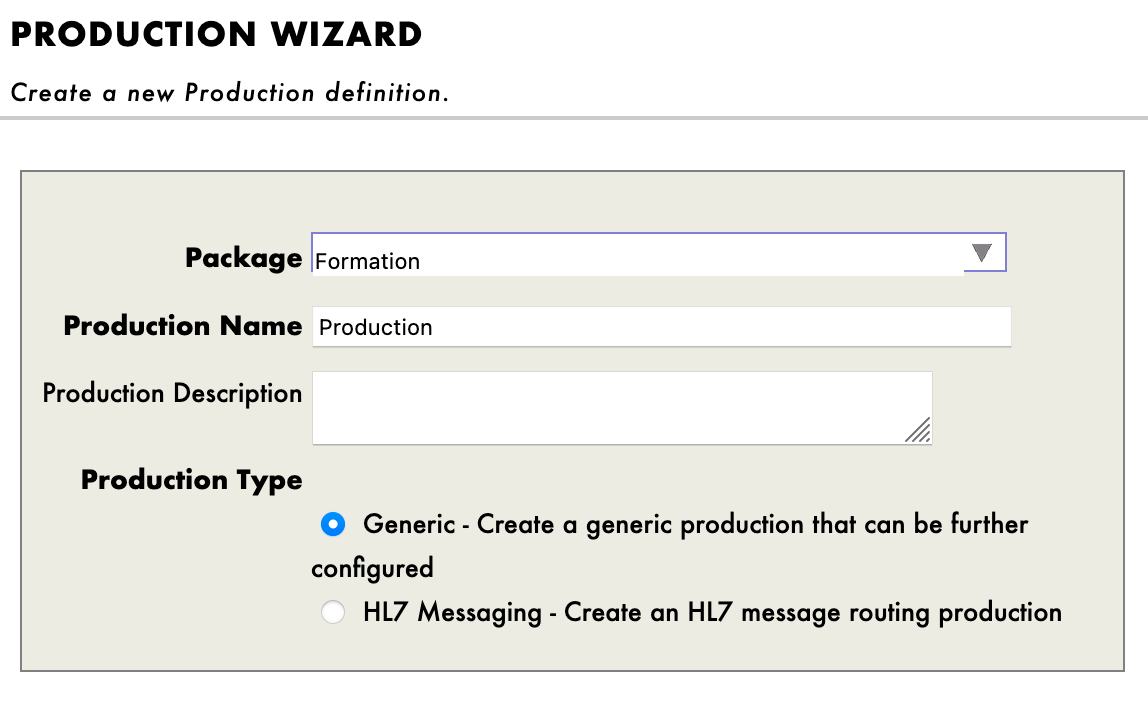

次に、[New] を押して [Formation] パッケージを選択し、本番環境の名前を設定します。

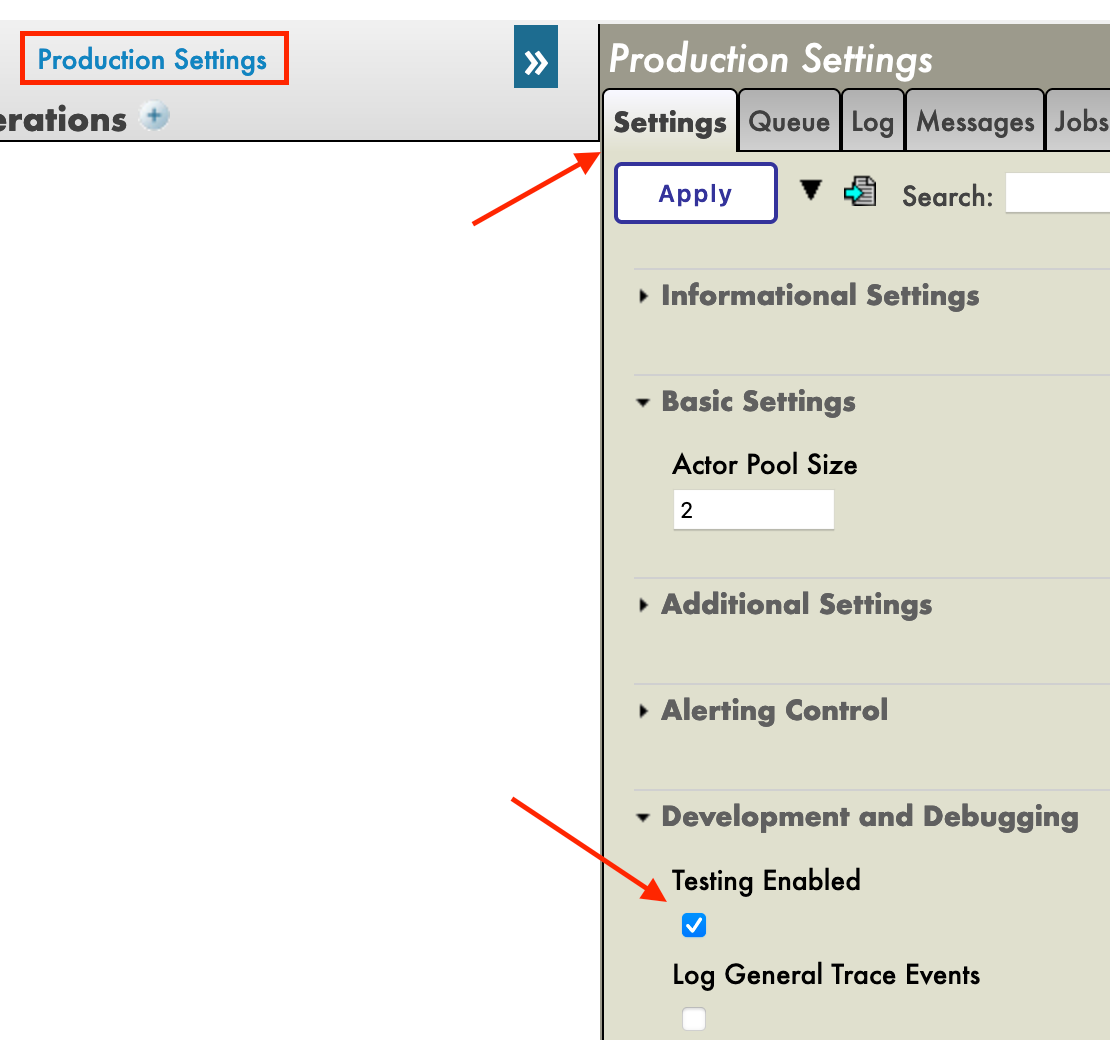

本番環境を作成した直後、[Operations] セクションの真上にある [Production Settings(本番環境の設定)] をクリックする必要があります。 右のサイドバーメニューで、[Settings] タブの [Development and Debugging(開発とデバッグ)] で [Testing Enabled(テストを有効)] をアクティブにします(忘れずに [Apply] を押してください)。

この最初の本番環境で、ビジネスオペレーションを追加していきます。

ビジネスオペレーション(BO)は、IRIS から外部アプリケーション/システムにリクエストを送信できるようにする特定のオペレーションです。 必要なものを IRIS に直接保存するためにも使用できます。

BO には、このインスタンスがソースからメッセージを受信するたびに呼び出される on_message 関数もあるため、フレームワークで確認できるように、情報を外部クライアントと送受信することが可能です。

これらのオペレーションは、VSCode でローカルに作成します。つまり、src/python/bo.py ファイルです。

このファイルを保存すると、IRIS でコンパイルされます。

ここでの最初のオペレーションでは、メッセージのコンテンツをローカルデータベースに保存し、同じ情報をローカルの .txt ファイルに書き込みます。

まずは、このメッセージを保存する方法を作成する必要があります。

dataclass を使用して、メッセージの情報を格納することにします。

すでに存在する src/python/obj.py ファイルを以下のようにします。

インポート:

from dataclasses import dataclass

コード:

@dataclass

class Formation:

id_formation:int = None

nom:str = None

salle:str = None

@dataclass

class Training:

name:str = None

room:str = None

Formation クラスは、csv の情報を格納して「8. ビジネスプロセス」に送信する Python オブジェクトとして使用し、Training クラスは、「8. ビジネスプロセス」から複数のオペレーションに情報を送信し、Iris データベースに保存するか .txt ファイルに書き込むために使用されます。

これらのメッセージには、7.1 で作成された obj.py ファイルにある Formation オブジェクトまたは Training オブジェクトが含まれます。

メッセージ、リクエスト、およびレスポンスはすべて grongier.pex.Message クラスの継承であることに注意してください。

すでに存在する src/python/msg.py ファイルを以下のようにします。

インポート:

from dataclasses import dataclass

from grongier.pex import Message

from obj import Formation,Training

コード:

@dataclass

class FormationRequest(Message):

formation:Formation = None

@dataclass

class TrainingRequest(Message):

training:Training = None

繰り返しますが、FormationRequest クラスは、csv の情報を格納して「8. ビジネスプロセス」に送信するメッセージとして使用し、TrainingRequest クラスは、「8. ビジネスプロセス」から複数のオペレーションに情報を送信し、Iris データベースに保存するか .txt ファイルに書き込むために使用されます。

必要な要素がすべて揃ったので、オペレーションを作成できるようになりました。

すべてのビジネスオペレーションは、grongier.pex.BusinessOperation クラスを継承していることに注意してください。

すべてのオペレーションは、src/python/bo.py に保存されます。これらを区別できるよう、ファイルに現時点で確認できるように複数のクラスを作成する必要があります。オペレーションのすべてのクラスはすでに存在していますが、現時点ではほぼ空の状態です。

オペレーションがメッセージ/リクエストを受信すると、各関数のシグネチャに指定されたメッセージ/リクエストの種類に応じて自動的に正しい関数にメッセージ/リクエストを送信します。 メッセージ/リクエストの種類が処理されない場合は、on_message 関数に転送されます。

すでに存在する src/python/bo.py ファイルを以下のようにします。

インポート:

from grongier.pex import BusinessOperation

import os

import iris

from msg import TrainingRequest,FormationRequest

FileOperation クラスのコード:

class FileOperation(BusinessOperation):

"""

トレーニングまたは患者をファイルに書き込むオペレーションです。

"""

def on_init(self):

"""

現在の作業ディレクトリを、オブジェクトの path 属性に指定されたディレクトリか、path 属性が指定されていない場合は /tmp ディレクトリに変更します。

また、filename 属性が設定されていない場合は、toto

.csv に設定します。

:return: None

"""

if hasattr(self,'path'):

os.chdir(self.path)

else:

os.chdir("/tmp")

return None

def write_training(self, request:TrainingRequest):

"""

ファイルにトレーニングを書き込みます。

:param request: The request message

:type request: TrainingRequest

:return: None

"""

romm = name = ""

if request.training is not None:

room = request.training.room

name = request.training.name

line = room+" : "+name+"\n"

filename = 'toto.csv'

self.put_line(filename, line)

return None

def on_message(self, request):

return None

def put_line(self,filename,string):

"""

ファイルを開き、文字列を追加し、ファイルを閉じます。

:param filename: The name of the file to write to

:param string: The string to be written to the file

"""

try:

with open(filename, "a",encoding="utf-8",newline="") as outfile:

outfile.write(string)

except Exception as error:

raise error

ご覧のとおり、FileOperation が msg.TrainingRequest タイプのメッセージを受信すると、request のシグネチャが TrainingRequest であるため、write_training 関数に送信されます。

この関数では、メッセージが格納する情報が toto.csv ファイルに書き込まれます。

path はオペレーションのパラメーターであるため、filename を管理ポータルで直接変更できる変数にし、基本値を toto.csv とすることができます。

このようにするには、on_init 関数を以下のように編集する必要があります。

def on_init(self):

if hasattr(self,'path'):

os.chdir(self.path)

else:

os.chdir("/tmp")

if not hasattr(self,'filename'):

self.filename = 'toto.csv'

return None

次に、オペレーションに直接コーディングして filename = 'toto.csv' を使用する代わりに、self.filename を呼び出します。

すると、write_training 関数は、以下のようになります。

def write_training(self, request:TrainingRequest):

romm = name = ""

if request.training is not None:

room = request.training.room

name = request.training.name

line = room+" : "+name+"\n"

self.put_line(self.filename, line)

return None

独自の filename の選択方法にいては、「7.5 テスト」をご覧ください。

情報を .txt ファイルに書き込めるようになりましたが、iris データベースはどうなっているでしょうか?src/python/bo.py ファイルでは、IrisOperation クラスのコードは以下のようになっています。

class IrisOperation(BusinessOperation):

"""

iris データベースにトレーニングを書き込むオペレーション

"""

def insert_training(self, request:TrainingRequest):

"""

`TrainingRequest` オブジェクトを取り、新しい行を `iris.training` テーブルに挿入し、

`TrainingResponse` オブジェクトを返します

:param request: 関数に渡されるリクエストオブジェクト

:type request: TrainingRequest

:return: TrainingResponse メッセージ

"""

sql = """

INSERT INTO iris.training

( name, room )

VALUES( ?, ? )

"""

iris.sql.exec(sql,request.training.name,request.training.room)

return None

def on_message(self, request):

return None

ご覧のとおり、IrisOperation が msg.TrainingRequest タイプのメッセージを受信すると、このメッセージが保有する情報は、iris.sql.exec IrisPython 関数によって SQL クエリに変換されて実行されます。 このメソッドによって、メッセージは IRIS ローカルデータベースに保存されます。

これらのコンポーネントは、事前に本番環境に登録済みです。

情報までに、コンポーネントを登録する手順は、5.4. に従い、以下を使用します。

register_component("bo","FileOperation","/irisdev/app/src/python/",1,"Python.FileOperation")

および、以下を使用します。

register_component("bo","IrisOperation","/irisdev/app/src/python/",1,"Python.IrisOperation")

オペレーションは、こちらで事前に登録済みです。

ただし、オペレーションを新規作成する場合は、手動で追加する必要があります。

今後の参考までに、オペレーションの登録手順を説明します。

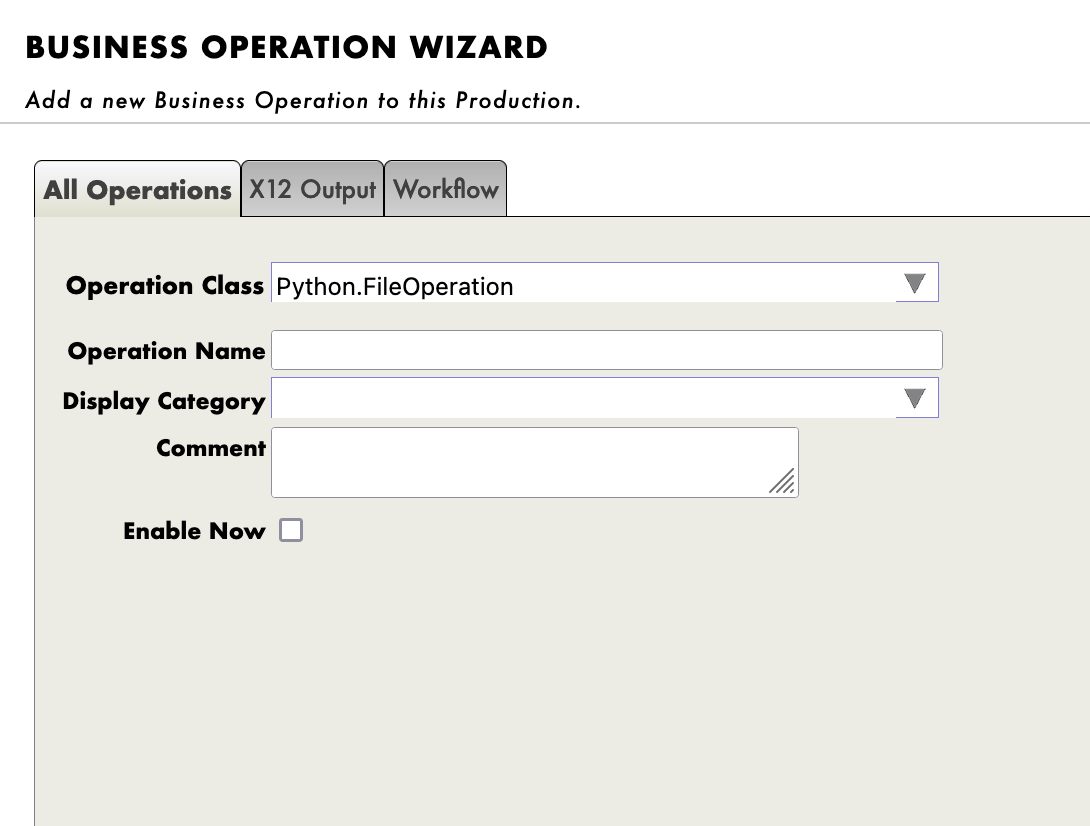

登録には、管理ポータルを使用します。 [Operations] の横にある [+] 記号を押すと、[Business Operation Wizard(ビジネスオペレーションウィザード)] が開きます。

そのウィザードで、スクロールメニューから作成したばかりのオペレーションクラスを選択します。

新しく作成したすべてのオペレーションに対して必ず実行してください!

オペレーションをダブルクリックすると、オペレーションが有効化されるか、再起動して変更内容が保存されます。

重要: この無効化して有効化し直す手順は、変更内容を保存する上で非常に重要な手順です。

重要: その後で、Python.IrisOperationオペレーションを選択し、右のサイドバーメニューの [Actions] タブに移動すると、オペレーションをテストすることができます。

(うまくいかない場合は、テストを有効化し、本番環境が開始していることを確認してから、本番環境をダブルクリックして再起動をクリックし、オペレーションをリロードしてください)。

IrisOperation については、テーブルは自動的に作成済みです。 情報までに、これを作成するには、管理ポータルを使用します。[System Explorer(システムエクスプローラー)] > [SQL] > [Go] に移動して、Iris データベースにアクセスします。 次に、[Execute Query(クエリを実行)] を開始します。

CREATE TABLE iris.training (

name varchar(50) NULL,

room varchar(50) NULL

)

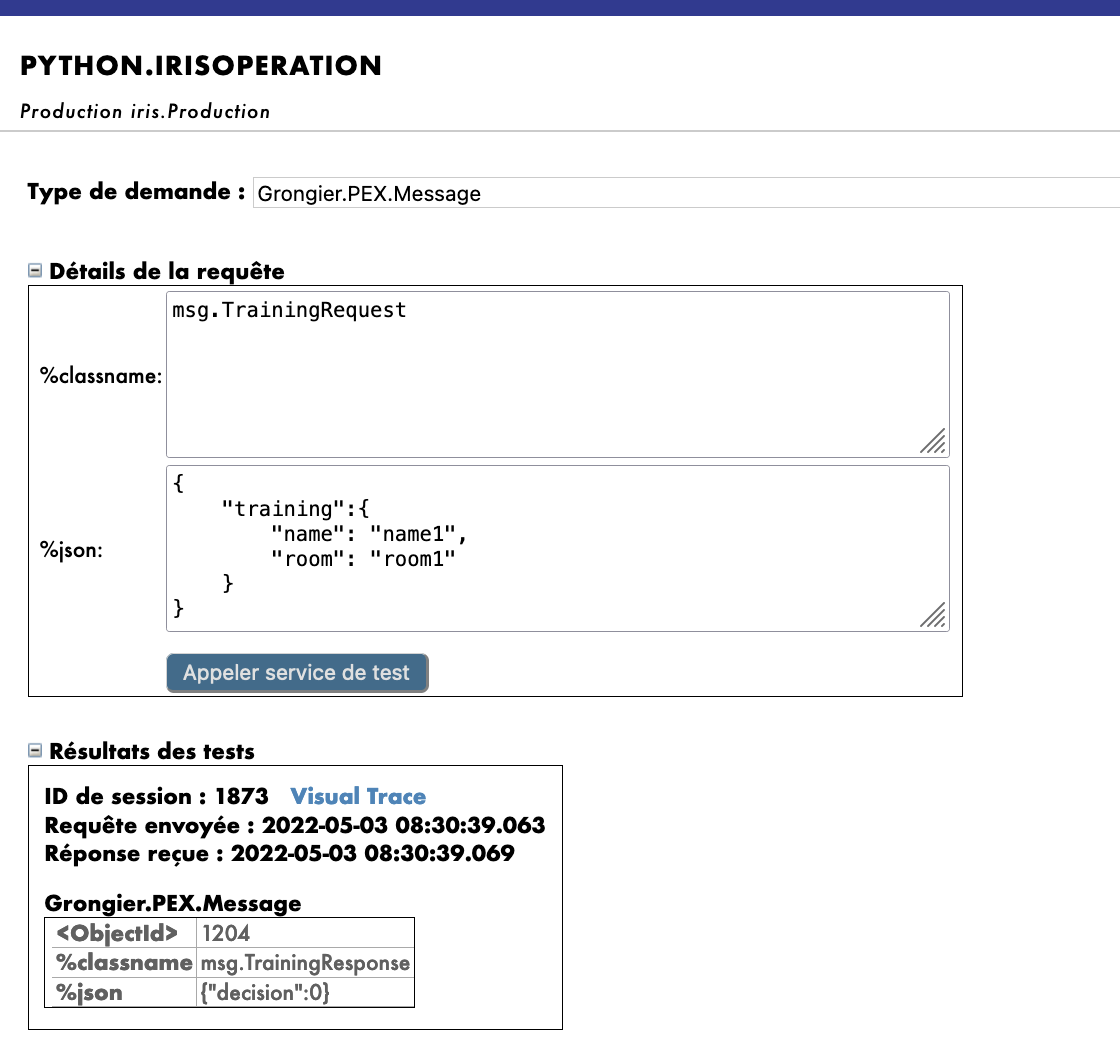

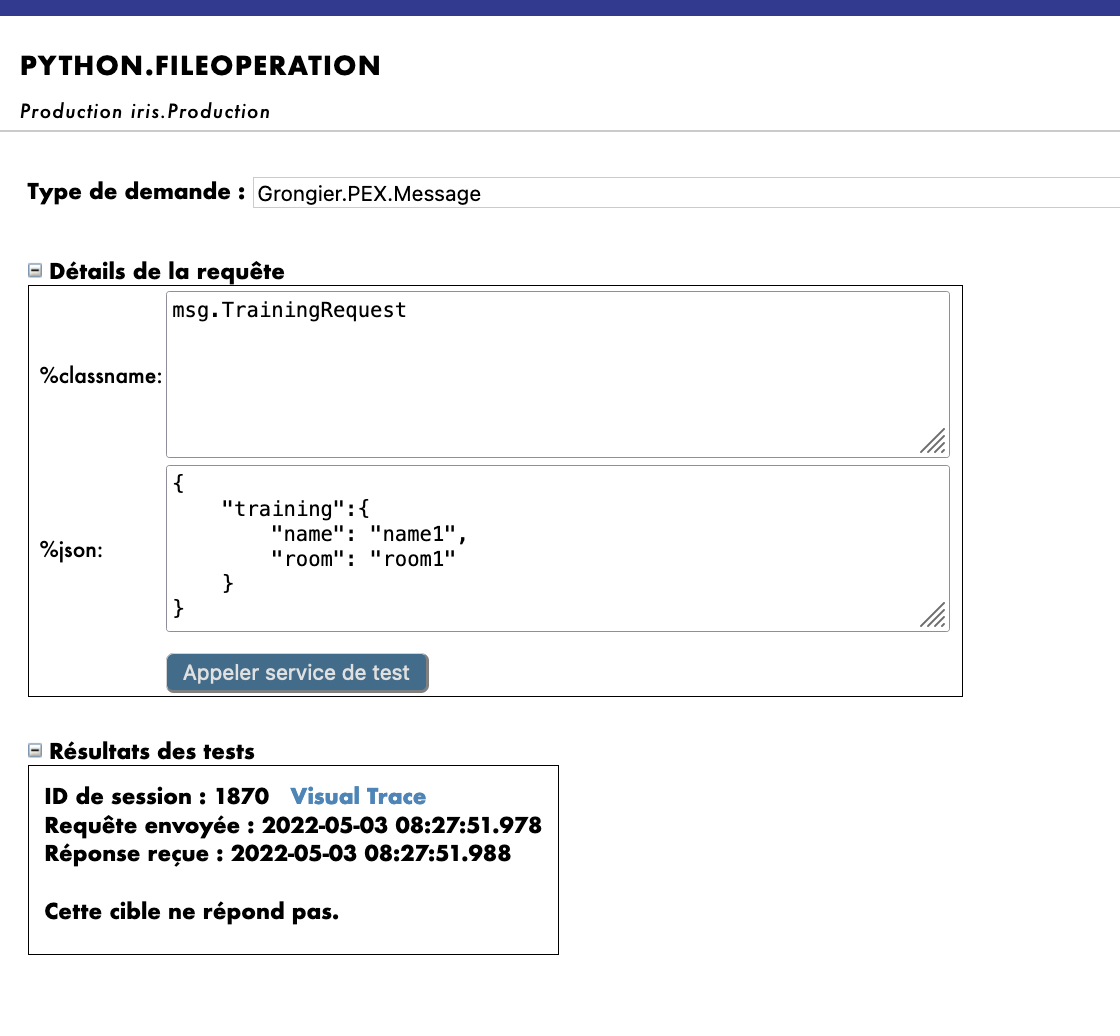

管理ポータルのテスト機能を使用して、前に宣言したタイプのメッセージをオペレーションに送信します。 すべてがうまくいけば、仮想トレースを表示すると、プロセスとサービスとオペレーション間で何が起きたかを確認できるようになります。Request Type として使用した場合:

Grongier.PEX.Message

%classname として使用した場合:

msg.TrainingRequest

%json として使用した場合:

{

"training":{

"name": "name1",

"room": "room1"

}

}

ここでは、メッセージがプロセスによってオペレーションに送信され、オペレーションがレスポンス(空の文字列)を送り返すのを確認できます。

以下のような結果が得られます。

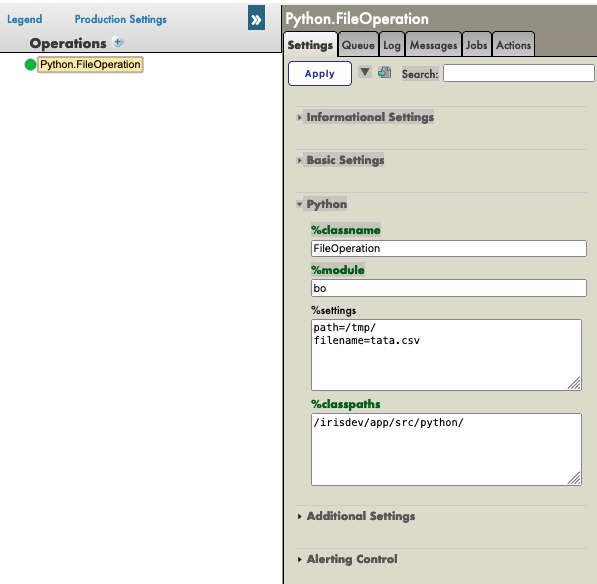

FileOperation については、以下のように管理ポータルの %settings に path を入力できます(7.3. の filename に関するメモに従った場合は、設定に filename を追加できます)。

path=/tmp/

filename=tata.csv

結果は以下のようになります。

繰り返しますが、Python.FileOperationオペレーションを選択して、右サイドバーメニューの [Actions] タブに移動すると、オペレーションをテストできます。

(うまくいかない場合は、テストを有効化し、本番環境が起動していることを確認してください)。Request Type として使用した場合:

Grongier.PEX.Message

%classname として使用した場合:

msg.TrainingRequest

%json として使用した場合:

{

"training":{

"name": "name1",

"room": "room1"

}

}

結果は以下のようになります。

オペレーションが動作したかどうかを確認するには、toto.csv(7.3. の filename に関するメモに従った場合は tata.csv)ファイルと Iris データベースにアクセスして変更内容を確認する必要があります。

次の手順を実行するには、コンテナの中に移動する必要がありますが、5.2. と 5.3 を実行した場合には、省略できます。

toto.csv にアクセスするには、ターミナルを開いて、以下を入力する必要があります。

bash

cd /tmp

cat toto.csv

または、必要であれば "cat tata.csv" を使用してください。

重要: ファイルが存在しない場合、管理ポータルでオペレーションを再起動していない可能性があります。

再起動するには、オペレーションをクリックして再起動を選択してください(または、無効化してからもう一度ダブルクリックして有効化してください)。

もう一度テストする必要があります。

Iris データベースにアクセスするには、管理ポータルにアクセスし、[System Explorer(システムエクスプローラー)] > [SQL] > [Go] を選択する必要があります。 次に、[Execute Query(クエリを実行)] を開始します。

SELECT * FROM iris.training

ビジネスプロセス(BP)は、本番環境のビジネスロジックです。 リクエストをプロセスしたり、本番環境の他のコンポーネントにそのリクエストをリレーしたリするために使用されます。

BP には、インスタンスがソースからリクエストを受信するたびに呼び出される on_request 関数もあるため、情報を受信して処理し、正しい BO に送信することができます。

これらのプロセスは、VSCode でローカルに作成します。つまり、src/python/bp.py ファイルです。

このファイルを保存すると、IRIS でコンパイルされます。

サービスから受信する情報を処理し、適切に配信するビジネスプロセスを作成しましょう。 オペレーションを呼び出す単純な BP を作成することにします。

この BP は情報をリダイレクトするだけであるため、これを Router と呼び、src/python/bp.py に作成します。

インポート:

from grongier.pex import BusinessProcess

from msg import FormationRequest, TrainingRequest

from obj import Training

コード:

class Router(BusinessProcess):

def on_request(self, request):

"""

リクエストを受信し、フォーメーションリクエストであるかを確認し、そうである場合は

TrainingRequest リクエストを FileOperation と IrisOperation に送信します。IrisOperation が 1 を返すと、PostgresOperation に送信します。

:param request: 受信したリクエストオブジェクト

:return: None

"""

if isinstance(request,FormationRequest):

msg = TrainingRequest()

msg.training = Training()

msg.training.name = request.formation.nom

msg.training.room = request.formation.salle

self.send_request_sync('Python.FileOperation',msg)

self.send_request_sync('Python.IrisOperation',msg)

return None

Router は FormationRequest タイプのリクエストを受信し、TrainingRequest タイプのメッセージを作成して IrisOperation と FileOperation オペレーションに送信します。 メッセージ/リクエストが求めているタイプのインスタンスでない場合、何も行わず、配信しません。

これらのコンポーネントは、事前に本番環境に登録済みです。

情報までに、コンポーネントを登録する手順は、5.4. に従い、以下を使用します。

register_component("bp","Router","/irisdev/app/src/python/",1,"Python.Router")

プロセスは、こちらで事前に登録済みです。

ただし、プロセスを新規作成する場合は、手動で追加する必要があります。

今後の参考までに、プロセスの登録手順を説明します。

登録には、管理ポータルを使用します。 [Process] の横にある [+] 記号を押すと、[Business Process Wizard(ビジネスプロセスウィザード)] が開きます。

そのウィザードで、スクロールメニューから作成したばかりのプロセスクラスを選択します。

プロセスをダブルクリックすると、プロセスが有効化されるか、再起動して変更内容が保存されます。

重要: この無効化して有効化し直す手順は、変更内容を保存する上で非常に重要な手順です。

重要: その後で、プロセスを選択し、右のサイドバーメニューの [Actions] タブに移動すると、プロセスをテストすることができます。

(うまくいかない場合は、テストを有効化し、本番環境が開始していることを確認してから、本番環境をダブルクリックして再起動をクリックし、プロセスをリロードしてください)。

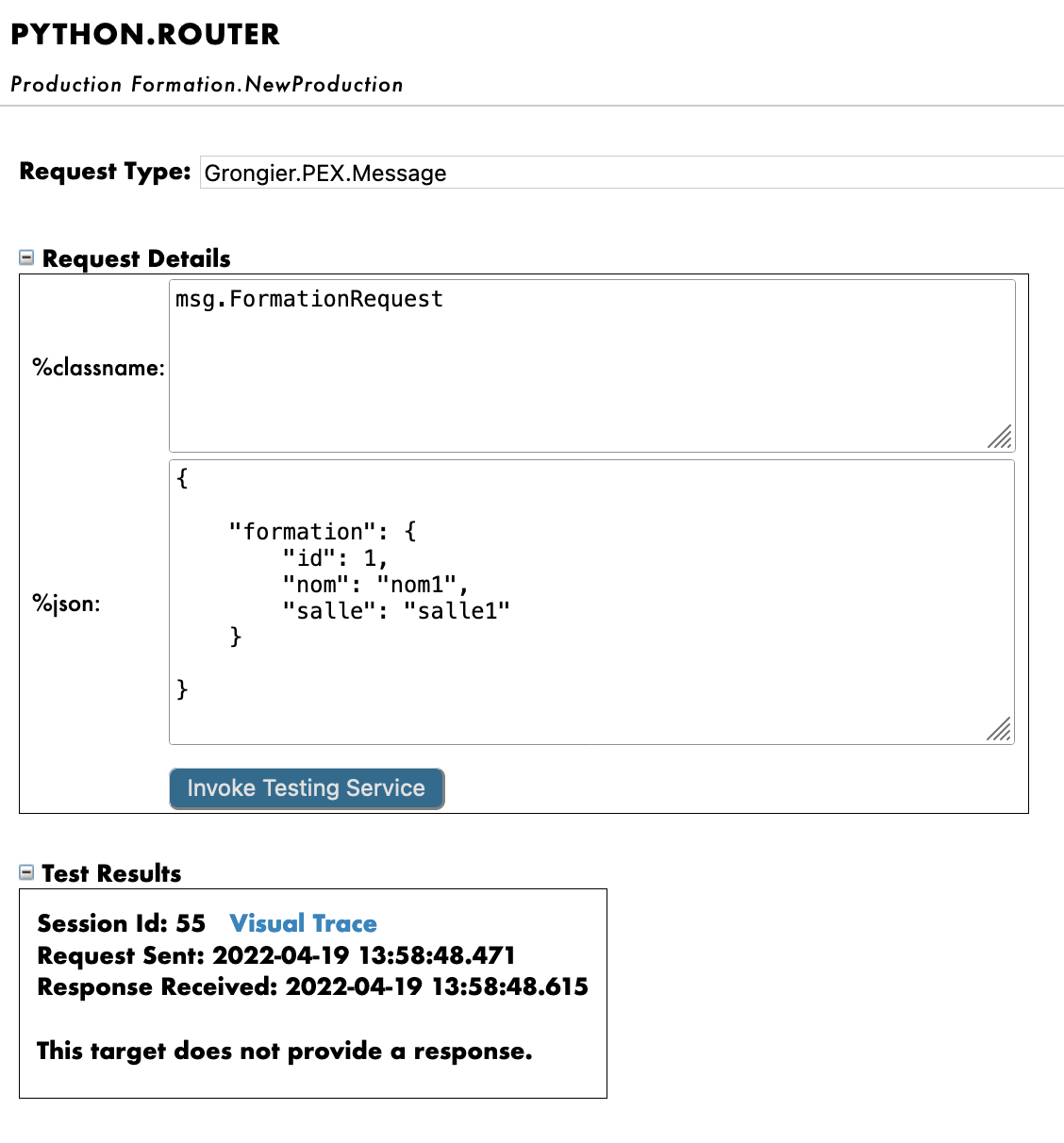

こうすることで、プロセスに msg.FormationRequest タイプのメッセージを送信します。 Request Type として使用した場合:

Grongier.PEX.Message

%classname として使用した場合:

msg.FormationRequest

%json として使用した場合:

{

"formation":{

"id_formation": 1,

"nom": "nom1",

"salle": "salle1"

}

}

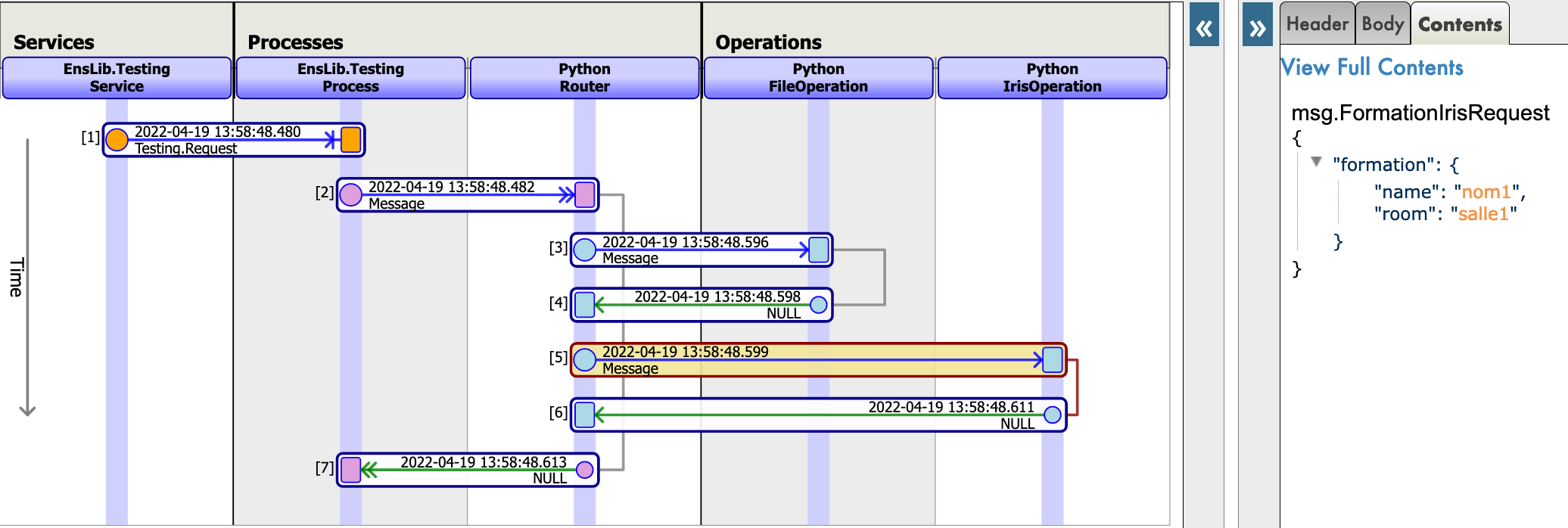

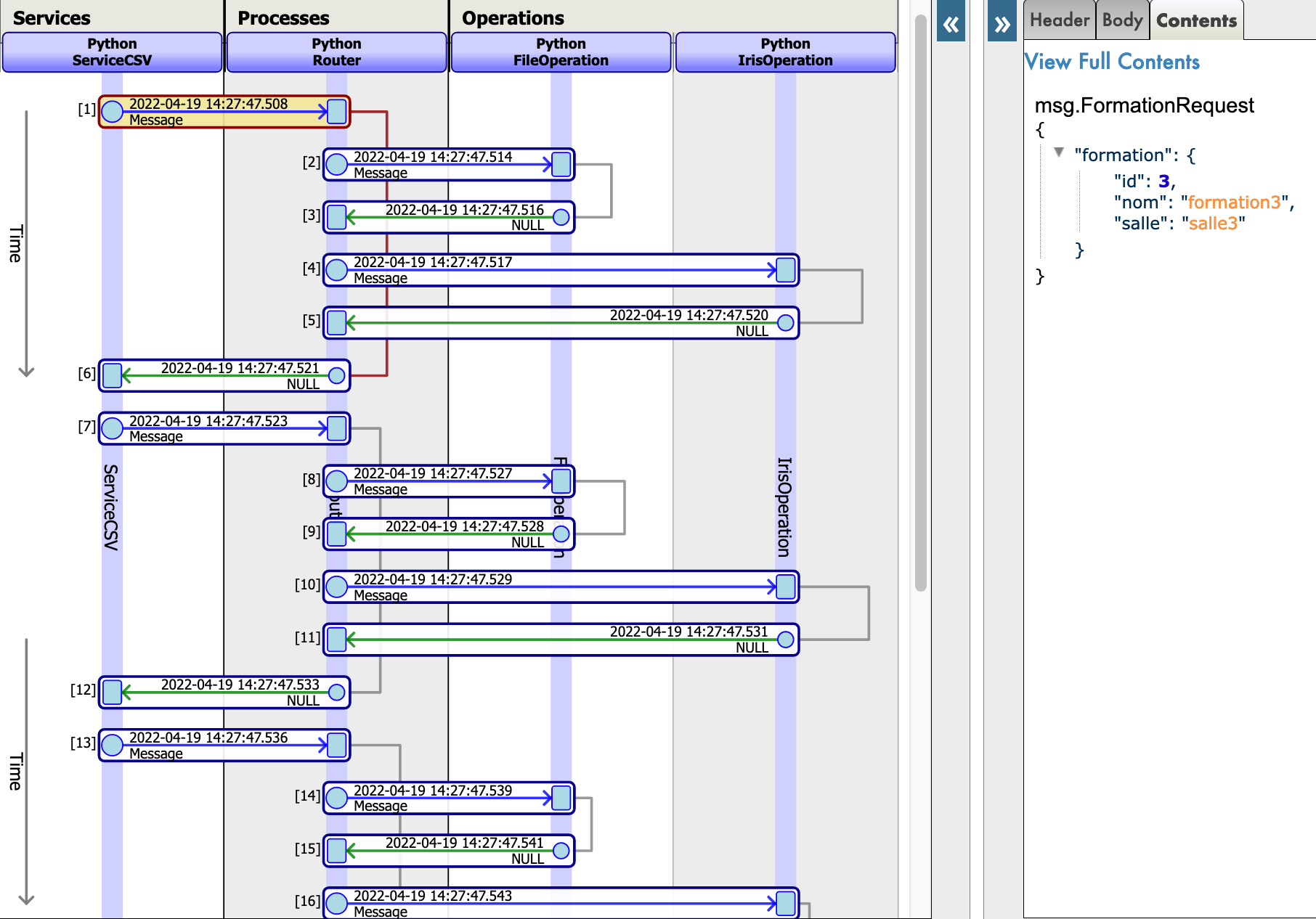

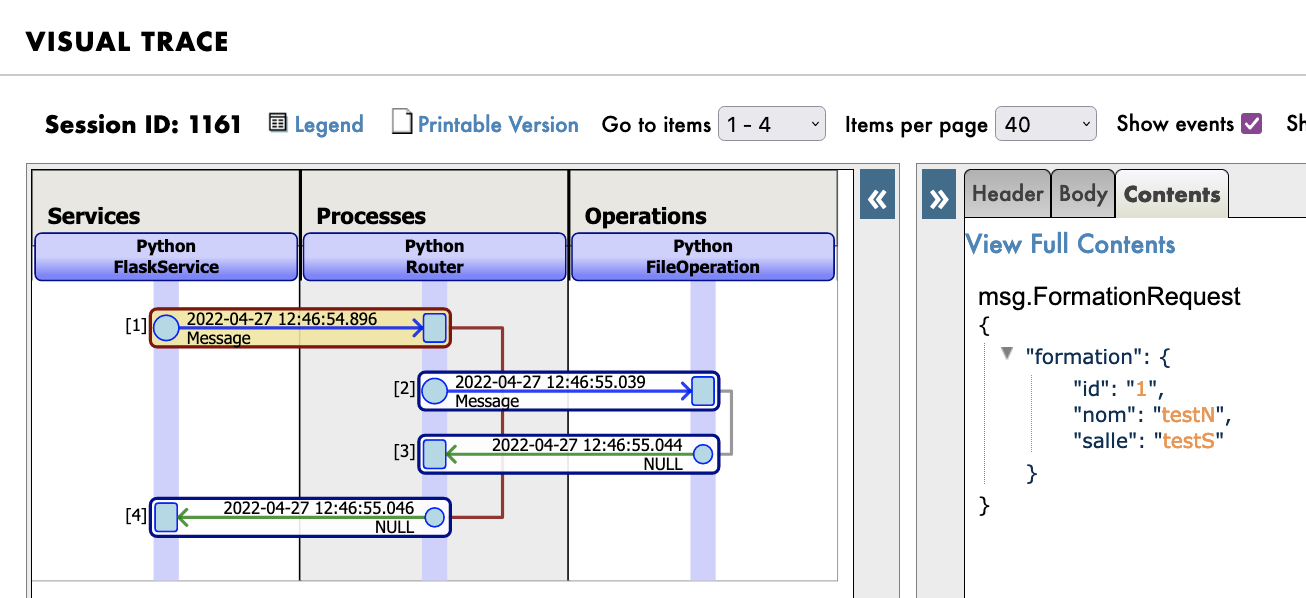

すべてがうまくいけば、仮想トレースを表示すると、プロセスとサービスとプロセス間で何が起きたかを確認できるようになります。

ここでは、メッセージがプロセスによってオペレーションに送信され、オペレーションがレスポンスを送り返すのを確認できます。

ビジネスサービス(BS)は、本番環境の中核です。 情報を収集し、ルーターに送信するために使用されます。 BS には、フレームワークの情報を頻繁に収集する on_process_input 関数もあるため、REST API やその他のサービス、またはサービス自体などの複数の方法で呼び出してサービスのコードをもう一度実行することが可能です。 BS には、クラスにアダプターを割り当てられる get_adapter_type 関数もあります。たとえば、Ens.InboundAdapter は、サービスがその on_process_input を 5 秒おきに呼び出すようにすることができます。

これらのサービスは、VSCode でローカルに作成します。つまり、python/bs.py ファイルです。

このファイルを保存すると、IRIS でコンパイルされます。

CSV を読み取って、msg.FormationRequest として各行をルーターに送信するビジネスサービスを作成しましょう。

この BS は csv を読み取るため、これを ServiceCSV と呼び、src/python/bs.py に作成します。

インポート:

from grongier.pex import BusinessService

from dataclass_csv import DataclassReader

from obj import Formation

from msg import FormationRequest

コード:

class ServiceCSV(BusinessService):

"""

csv ファイルを 5 秒おきに読み取り、メッセージとして各行を Python Router プロセスに送信します。

"""

def get_adapter_type():

"""

登録済みのアダプタ名

"""

return "Ens.InboundAdapter"

def on_init(self):

"""

現在のファイルパスをオブジェクトの path 属性に指定されたパスに変更します。

path 属性が指定されていない場合は '/irisdev/app/misc/' に変更します。

:return: None

"""

if not hasattr(self,'path'):

self.path = '/irisdev/app/misc/'

return None

def on_process_input(self,request):

"""

formation.csv ファイルを読み取り、各行のFormationRequest メッセージを作成し、

Python.Router プロセスに送信します。

:param request: リクエストオブジェクト

:return: None

"""

filename='formation.csv'

with open(self.path+filename,encoding="utf-8") as formation_csv:

reader = DataclassReader(formation_csv, Formation,delimiter=";")

for row in reader:

msg = FormationRequest()

msg.formation = row

self.send_request_sync('Python.Router',msg)

return None

FlaskService はそのままにし、ServiceCSV のみを入力することをお勧めします。

ご覧のとおり、ServiceCSV は、独立して機能し、5 秒おき(管理ポータルのサービスの設定にある基本設定で変更できるパラメーター)に on_process_input を呼び出せるようにする InboundAdapter を取得します。

サービスは、5 秒おきに formation.csv を開き、各行を読み取って、Python.Router に送信される msg.FormationRequest を作成します。

これらのコンポーネントは、事前に本番環境に登録済みです。

情報までに、コンポーネントを登録する手順は、5.4. に従い、以下を使用します。

register_component("bs","ServiceCSV","/irisdev/app/src/python/",1,"Python.ServiceCSV")

サービスは、こちらで事前に登録済みです。

ただし、サービスを新規作成する場合は、手動で追加する必要があります。

今後の参考までに、サービスの登録手順を説明します。

登録には、管理ポータルを使用します。 [service] の横にある [+] 記号を押すと、[Business Service Wizard(ビジネスサービスウィザード)] が開きます。

そのウィザードで、スクロールメニューから作成したばかりのサービスクラスを選択します。

サービスをダブルクリックすると、サービスが有効化されるか、再起動して変更内容が保存されます。

重要: この無効化して有効化し直す手順は、変更内容を保存する上で非常に重要な手順です。

前に説明したように、サービスは 5 秒おきに自動的に開始するため、ここでは他に行うことはありません。

すべてがうまくいけば、視覚的トレースを表示すると、プロセスとサービスとプロセス間で何が起きたかを確認することができます。

ここでは、メッセージがサービスによってプロセスに送信され、プロセスによってオペレーションに送信され、オペレーションがレスポンスを送り返すのを確認できます。

このセクションでは、外部データベースにオブジェクトを保存するオペレーションを作成します。 db-api を使用し、その他の Docker コンテナをセットアップして Postgres を設定します。

Postgres を使用するには psycopg2 が必要です。これは、単純なコマンドで Postgres データベースに接続できるようにする Python モジュールです。

これは自動的に完了済みですが、情報までに説明すると、Docker コンテナにアクセスし、pip3 を使って psycopg2 をインストールします。

ターミナルを開始したら、以下を入力します。

pip3 install psycopg2-binary

または、requirements.txt にモジュールを追加して、コンテナを再構築できます。

新しいオペレーションは、src/python/bo.py ファイルの他の 2 つのオペレーションの後に追加してください。 以下は、新しいオペレーションとインポートです。

インポート:

import psycopg2

コード:

class PostgresOperation(BusinessOperation):

"""

トレーニングを Postgres データベースに書き込むオペレーションです。

"""

def on_init(self):

"""

Postgres データベースに接続して接続オブジェクトを初期化する関数です。

:return: None

"""

self.conn = psycopg2.connect(

host="db",

database="DemoData",

user="DemoData",

password="DemoData",

port="5432")

self.conn.autocommit = True

return None

def on_tear_down(self):

"""

データベースへの接続を閉じます。

:return: None

"""

self.conn.close()

return None

def insert_training(self,request:TrainingRequest):

"""

トレーニングを Postgre データベースに挿入します。

:param request: 関数に渡されるリクエストオブジェクト

:type request: TrainingRequest

:return: None

"""

cursor = self.conn.cursor()

sql = "INSERT INTO public.formation ( name,room ) VALUES ( %s , %s )"

cursor.execute(sql,(request.training.name,request.training.room))

return None

def on_message(self,request):

return None

このオペレーションは、最初に作成したオペレーションに似ています。 msg.TrainingRequest タイプのメッセージを受信すると、psycopg モジュールを使用して、SQL リクエストを実行します。 これらのリクエストは、Postgres データベースに送信されます。

ご覧のとおり、接続はコードに直接書き込まれています。コードを改善するために、他のオペレーションで前に行ったようにし、host、database、およびその他の接続情報を変数にすることができます。基本値を db や DemoData にし、管理ポータルで直接変更できるようにします。

これを行うには、以下のようにして on_init を変更します。

def on_init(self):

if not hasattr(self,'host'):

self.host = 'db'

if not hasattr(self,'database'):

self.database = 'DemoData'

if not hasattr(self,'user'):

self.user = 'DemoData'

if not hasattr(self,'password'):

self.password = 'DemoData'

if not hasattr(self,'port'):

self.port = '5432'

self.conn = psycopg2.connect(

host=self.host,

database=self.database,

user=self.user,

password=self.password,

port=self.port)

self.conn.autocommit = True

return None

これらのコンポーネントは、事前に本番環境に登録済みです。

情報までに、コンポーネントを登録する手順は、5.4. に従い、以下を使用します。

register_component("bo","PostgresOperation","/irisdev/app/src/python/",1,"Python.PostgresOperation")

オペレーションは、こちらで事前に登録済みです。

ただし、オペレーションを新規作成する場合は、手動で追加する必要があります。

今後の参考までに、オペレーションの登録手順を説明します。

登録には、管理ポータルを使用します。 [Operations] の横にある [+] 記号を押すと、[Business Operation Wizard(ビジネスオペレーションウィザード)] が開きます。

そのウィザードで、スクロールメニューから作成したばかりのオペレーションクラスを選択します。

その後、接続を変更する場合は、オペレーションの [parameter] ウィンドウで、[Python] の %settings に変更するパラメーターを追加すれば完了です。 詳細については、「7.5 テスト」の 2 つ目の画像をご覧ください。

オペレーションをダブルクリックすると、オペレーションが有効化されるか、再起動して変更内容が保存されます。

重要: この無効化して有効化し直す手順は、変更内容を保存する上で非常に重要な手順です。

重要: その後で、オペレーションを選択し、右のサイドバーメニューの [Actions] タブに移動すると、オペレーションをテストすることができます。

(うまくいかない場合は、テストを有効化し、本番環境が開始していることを確認してから、本番環境をダブルクリックして再起動をクリックし、オペレーションをリロードしてください)。

PostGresOperation については、テーブルは自動的に作成済みです。

こうすることで、オペレーションに msg.TrainingRequest タイプのメッセージを送信します。 Request Type として使用した場合:

Grongier.PEX.Message

%classname として使用した場合:

msg.TrainingRequest

%json として使用した場合:

{

"training":{

"name": "nom1",

"room": "salle1"

}

}

以下のとおりです。

仮想トレースをテストすると、成功が表示されます。

これで、外部データベースに接続することができました。

ここまで、ここに記載の情報に従ってきた場合、プロセスやサービスは新しい PostgresOperation を呼び出さない、つまり、管理ポータルのテスト機能を使用しなければ呼び出されないことを理解していることでしょう。

演習として、bo.IrisOperation がブール値を返すように変更し、そのブール値に応じて bp.Router に bo.PostgresOperation を呼び出すようにしてみましょう。

そうすることで、ここで新しく作成したオペレーションが呼び出されるようになります。

ヒント: これは、bo.IrisOperation レスポンスの戻り値のタイプを変更し、新しいメッセージ/レスポンスタイプに新しいブール値プロパティを追加して、bp.Router に if 操作を使用すると実現できます。

まず、bo.IrisOperation からのレスポンスが必要です。 src/python/msg.py の他の 2 つのメッセージの後に、以下のようにして新しいメッセージを作成します。

コード:

@dataclass

class TrainingResponse(Message):

decision:int = None

次に、そのレスポンスによって、bo.IrisOperation のレスポンスを変更し、decision の値を 1 または 0 にランダムに設定します。src/python/bo.py で 2 つのインポートを追加し、IrisOperation クラスを変更する必要があります。

インポート:

import random

from msg import TrainingResponse

コード:

class IrisOperation(BusinessOperation):

"""

トレーニングを iris データベースに書き込むオペレーションです。

"""

def insert_training(self, request:TrainingRequest):

"""

`TrainingRequest` オブジェクトを取り、新しい行を`iris.training` テーブルに挿入し、

`TrainingResponse` オブジェクトを返します。

:param request: 関数に渡されるリクエストオブジェクト

:type request: TrainingRequest

:return: A TrainingResponse message

"""

resp = TrainingResponse()

resp.decision = round(random.random())

sql = """

INSERT INTO iris.training

( name, room )

VALUES( ?, ? )

"""

iris.sql.exec(sql,request.training.name,request.training.room)

return resp

def on_message(self, request):

return None

class Router(BusinessProcess):

def on_request(self, request):

"""

リクエストを受け取り、フォーメーションリクエストであるかどうかをチェックします。

その場合は、TrainingRequest リクエストを FileOperation と IrisOperation に送信し、IrisOperation が 1 を返すと PostgresOperation に送信します。

:param request: 受信したリクエストオブジェクト

:return: None

"""

if isinstance(request,FormationRequest):

msg = TrainingRequest()

msg.training = Training()

msg.training.name = request.formation.nom

msg.training.room = request.formation.salle

self.send_request_sync('Python.FileOperation',msg)

form_iris_resp = self.send_request_sync('Python.IrisOperation',msg)

if form_iris_resp.decision == 1:

self.send_request_sync('Python.PostgresOperation',msg)

return None

非常に重要: オペレーションの呼び出しには、send_request_async ではなく、必ず send_request_sync を使用する必要があります。そうでない場合、この操作はブール値のレスポンスを受け取る前に実行されます。

テストする前に、必ず変更したすべてのサービス、プロセス、およびオペレーションをダブルクリックして再起動してください。これを行わない場合、変更内容は適用されません。

テスト後、視覚的トレースで、csv で読み取られたおよそ半数のオブジェクトがリモートデータベースにも保存されていることがわかります。bs.ServiceCSV を開始するだけでテストできることに注意してください。リクエストは自動的にルーターに送信され、適切に配信されます。

また、サービス、オペレーション、またはプロセスをダブルクリックしてリロードを押すか、VSCode で保存した変更を適用するには再起動を押す必要があることにも注意してください。

ここでは、REST サービスを作成して使用します。

Flask を使用するには、flask のインストールが必要です。これは、REST サービスを簡単に作成できるようにする Python モジュールです。 これは、自動的に実行済みですが、今後の情報までに説明すると、Docker コンテナ内にアクセスして iris python に flask をインストールします。 ターミナルを開始したら、以下を入力します。

pip3 install flask

または、requirements.txt にモジュールを追加して、コンテナを再構築できます。

REST サービスを作成するには、API を本番環境にリンクするサービスが必要です。このために、src/python/bs.py の ServiceCSV クラスの直後に新しい単純なサービスを作成します。

class FlaskService(BusinessService):

def on_init(self):

"""

API の現在のターゲットをオブジェクトの target 属性に指定されたターゲットに変更します。

または、target 属性が指定されていない場合は 'Python.Router' に変更します。

:return: None

"""

if not hasattr(self,'target'):

self.target = "Python.Router"

return None

def on_process_input(self,request):

"""

API から直接 Python.Router プロセスに情報を送信するために呼び出されます。

:return: None

"""

return self.send_request_sync(self.target,request)

このサービスに on_process_input を行うと、リクエストが Router に転送されます。

これらのコンポーネントは、事前に本番環境に登録済みです。

情報までに、コンポーネントを登録する手順は、5.4. に従い、以下を使用します。

register_component("bs","FlaskService","/irisdev/app/src/python/",1,"Python.FlaskService")

REST サービスを作成するには、Flask を使って get と post 関数を管理する API を作成する必要があります。 新しいファイルを python/app.py として作成してください。

from flask import Flask, jsonify, request, make_response

from grongier.pex import Director

import iris

from obj import Formation

from msg import FormationRequest

app = Flask(__name__)

# GET Infos

@app.route("/", methods=["GET"])

def get_info():

info = {'version':'1.0.6'}

return jsonify(info)

# GET all the formations

@app.route("/training/", methods=["GET"])

def get_all_training():

payload = {}

return jsonify(payload)

# POST a formation

@app.route("/training/", methods=["POST"])

def post_formation():

payload = {}

formation = Formation()

formation.nom = request.get_json()['nom']

formation.salle = request.get_json()['salle']

msg = FormationRequest(formation=formation)

service = Director.CreateBusinessService("Python.FlaskService")

response = service.dispatchProcessInput(msg)

return jsonify(payload)

# GET formation with id

@app.route("/training/<int:id>", methods=["GET"])

def get_formation(id):

payload = {}

return jsonify(payload)

# PUT to update formation with id

@app.route("/training/<int:id>", methods=["PUT"])

def update_person(id):

payload = {}

return jsonify(payload)

# DELETE formation with id

@app.route("/training/<int:id>", methods=["DELETE"])

def delete_person(id):

payload = {}

return jsonify(payload)

if __name__ == '__main__':

app.run('0.0.0.0', port = "8081")

Flask API は Director を使用して、前述のものから FlaskService のインスタンスを作成してから適切なリクエストを送信することに注意してください。

上記の子k-度では、POST フォーメンション関数を作成しました。希望するなら、これまでに学習したものすべてを使用して、適切な情報を get/post するように、他の関数を作成することが可能です。ただし、これに関するソリューションは提供されていません。

Python Flask を使用して flask アプリを開始しましょう。

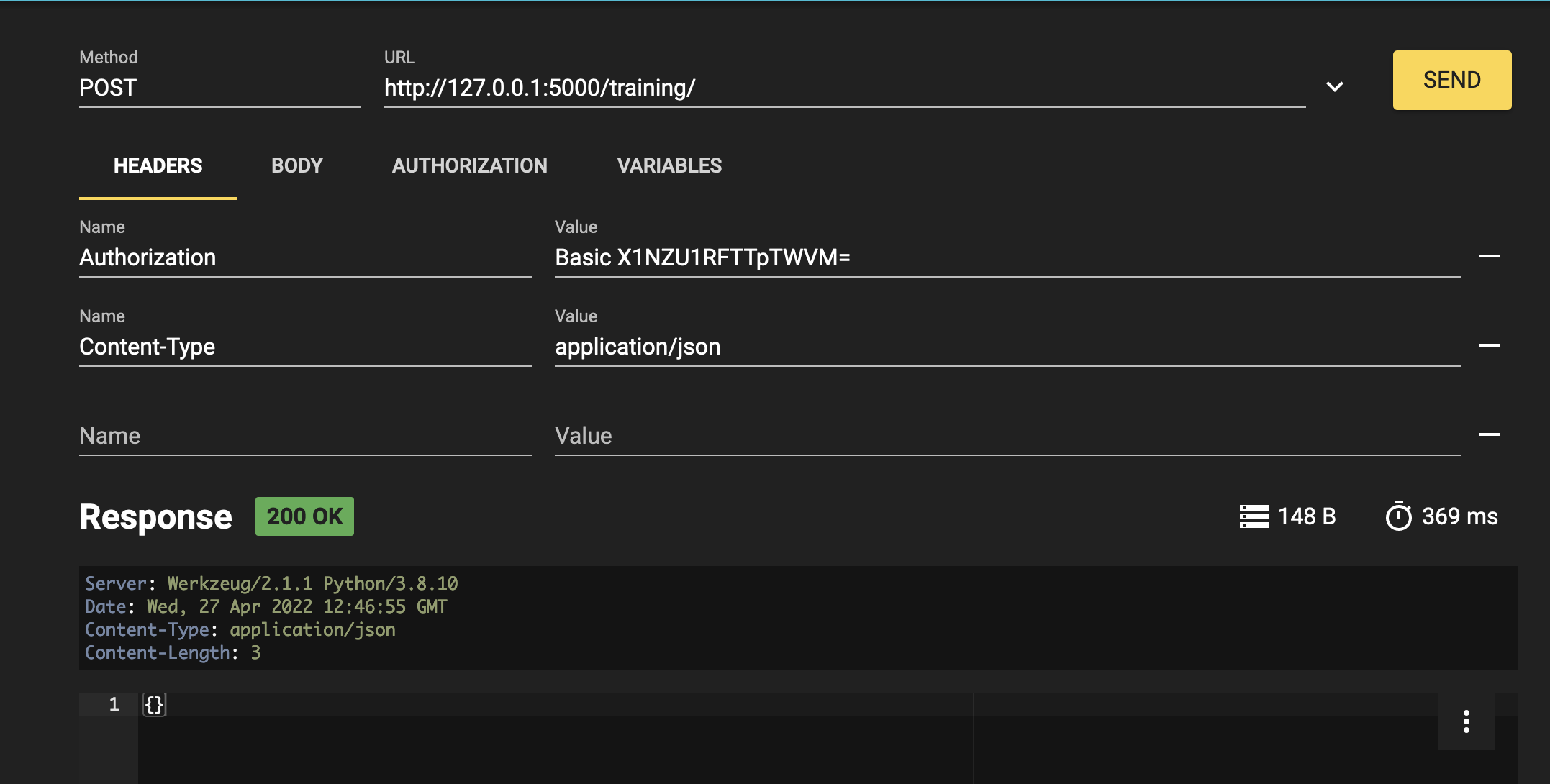

最後に、Router サービスをリロードしてから、任意の REST クライアントを使用してサービスをテストできます。

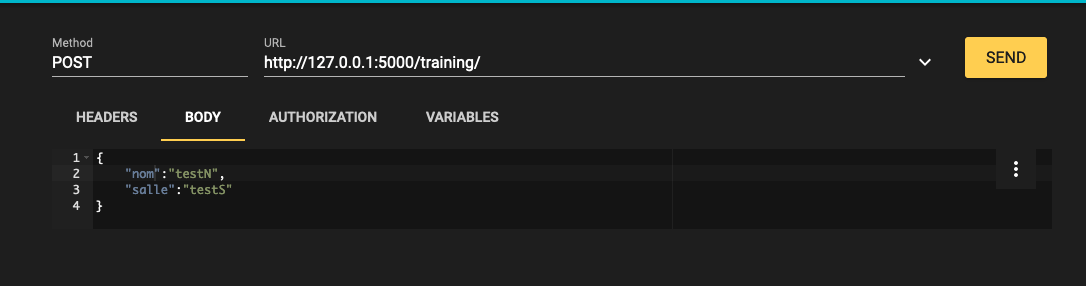

(Mozilla の RESTer として)REST サービスを使用するには、以下のようにヘッダーを入力する必要があります。

Content-Type : application/json

ボディは以下のようになります。

{

"nom":"testN",

"salle":"testS"

}

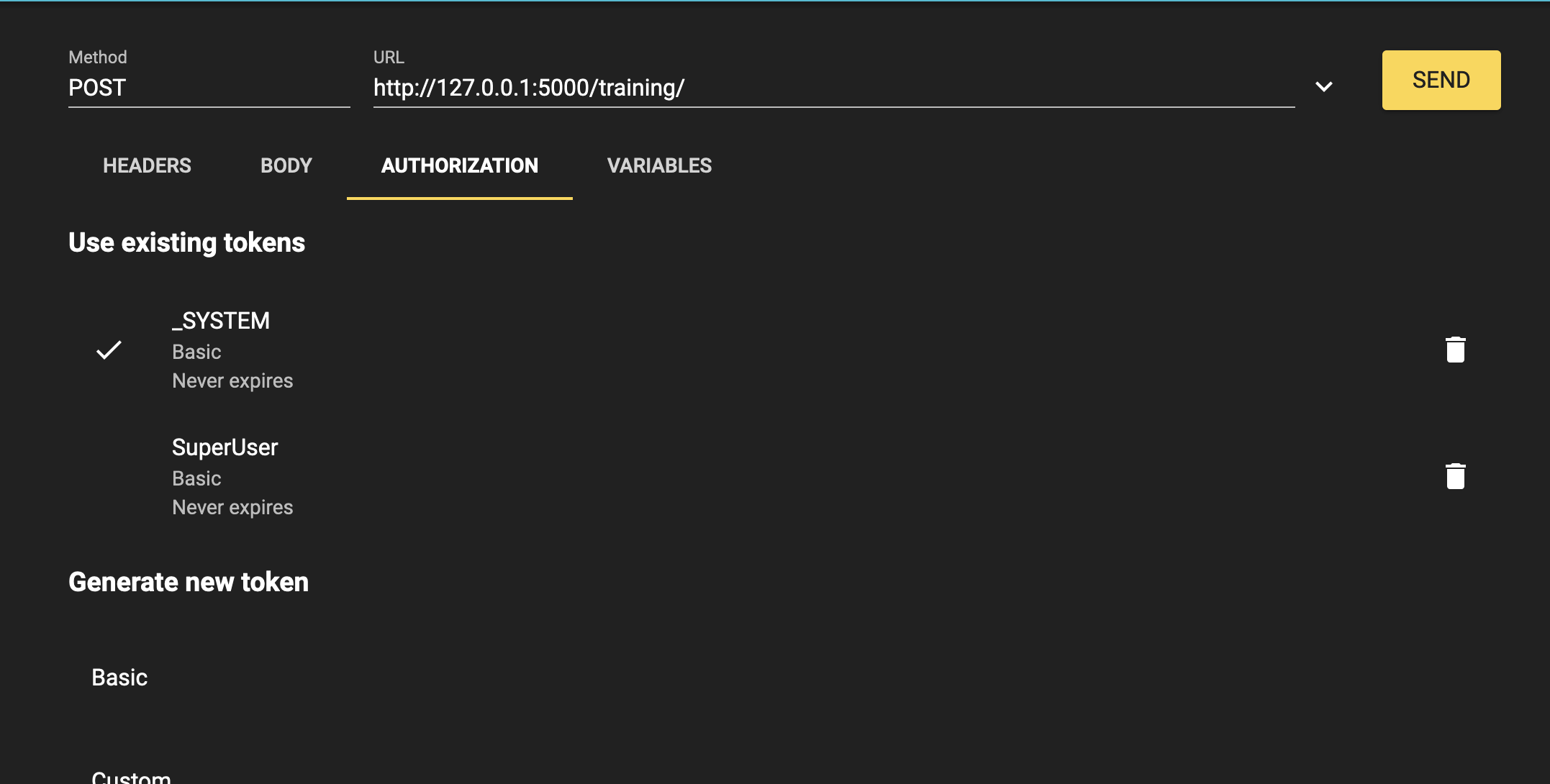

認証は以下のとおりです。

ユーザー名:

SuperUser

パスワード:

SYS

最後に、結果は以下のようになります。

Iris DataPlatform とそのフレームワークのすべての重要な概念について学習したので、グローバル演習で腕試しをしましょう。この演習では、新しい BS と BP を作成し、BO を大きく変更して、新しい概念を Python で探ります。

こちらのエンドポイントhttps://lucasenard.github.io/Data/patients.json を使用して、患者と歩数に関する情報を自動的に取得するようにします。 次に、ローカルの csv ファイルに書き込む前に、各患者の平均歩数を計算します。

必要であれば、フォーメーション全体または必要な箇所を読むか、以下のヒントを使って、ガイダンスを得ることをお勧めします。

管理ポータルでコンポーネントにアクセスできるように、コンポーネントの登録を忘れずに行いましょう。

すべてを完了し、テストしたら、または演習を完了するのに十分なヒントを得られなかった場合は、全過程をステップごとに説明したソリューションをご覧ください。

ここでは、演習を行うためのヒントを紹介します。

読んだ分だけヒントが得られてしまうため、必要な箇所のみを読み、毎回すべてを読まないようにすることをお勧めします。

たとえば、bs の「情報の取得」と「リクエストによる情報の取得」のみを読み、他は読まないようにしましょう。

エンドポイントから情報を取得するには、Python の requests モジュールを検索し、json と json.dumps を使用して文字列に変換してから bp に送信します。

オンライン Python Web サイトまたはローカルの Python ファイルを使用してリクエストを使用し、取得した内容をさらに深く理解するために、出力とそのタイプを出力します。

新しいメッセージタイプと情報を保持するオブジェクトタイプを作成し、プロセスに送信して平均を計算します。

リクエストを使用してデータを取得する方法と、この場合に部分的に、それをどう処理するかに関するソリューションです。

r = requests.get(https://lucasenard.github.io/Data/patients.json)

data = r.json()

for key,val in data.items():

...

繰り返しますが、オンライン Python Web サイトまたはローカルの Python ファイルでは、key、val、およびタイプを出力し、それらを使用して何をできるかを理解することが可能です。json.dumps(val) を使用して val を格納してから、SendRequest の後にプロセスにいるときに、json.loads(request.patient.infos) を使用してその val を取得します(val の情報を patient.infos に格納した場合)。

statistics は、算術演算を行うために使用できるネイティブライブラリです。

Python のネイティブ map 関数では、たとえばリスト内または辞書内の情報を分離することができます。

list ネイティブ関数を使用して、map の結果をリストに変換し直すことを忘れないようにしましょう。

オンライン Python Web サイトまたはローカルの Python ファイルを使用して、以下のように、リストのリストまたは辞書のリストの平均を計算することができます。

l1 = [[0,5],[8,9],[5,10],[3,25]]

l2 = [["info",12],["bidule",9],[3,3],["patient1",90]]

l3 = [{"info1":"7","info2":0},{"info1":"15","info2":0},{"info1":"27","info2":0},{"info1":"7","info2":0}]

#最初のリストの最初の列の平均(0/8/5/3)

avg_l1_0 = statistics.mean(list(map(lambda x: x[0]),l1))

#最初のリストの 2 つ目列の平均(5/9/10/25)

avg_l1_1 = statistics.mean(list(map(lambda x: x[1]),l1))

#12/9/3/90 の平均

avg_l2_1 = statistics.mean(list(map(lambda x: x[1]),l2))

#7/15/27/7 の平均

avg_l3_info1 = statistics.mean(list(map(lambda x: int(x["info1"])),l3))

print(avg_l1_0)

print(avg_l1_1)

print(avg_l2_1)

print(avg_l3_info1)

リクエストに、日付と歩数の dict の json.dumps である infos 属性を持つ患者が保持されている場合、以下のようにして平均歩数を計算できます。

statistics.mean(list(map(lambda x: int(x['steps']),json.loads(request.patient.infos))))

bo.FileOperation.WriteFormation に非常に似たものを使用できます。

bo.FileOperation.WritePatient のようなものです。

obj.py に以下を追加できます。

@dataclass

class Patient:

name:str = None

avg:int = None

infos:str = None

msg.py に以下を追加できます。

インポート:

from obj import Formation,Training,Patient

コード:

@dataclass

class PatientRequest(Message):

patient:Patient = None

この情報を単一の obj に保持し、get リクエストから得る dict の str を直接 infos 属性に入れます。 平均は、プロセスで計算されます。

bs.py に以下を追加できます。 インポート:

import requests

コード:

class PatientService(BusinessService):

def get_adapter_type():

"""

登録されたアダプタの名前

"""

return "Ens.InboundAdapter"

def on_init(self):

"""

API の現在のターゲットをオブジェクトの target 属性に指定されたターゲットに変更します。

target 属性が指定されていない場合は、'Python.PatientProcess' に変更します。

API の現在の api_url をオブジェクトの taget 属性に指定された api_url に変更します。

api_url 属性が指定されていない場合は、'https://lucasenard.github.io/Data/patients.json' に変更します。

:return: None

"""

if not hasattr(self,'target'):

self.target = 'Python.PatientProcess'

if not hasattr(self,'api_url'):

self.api_url = "https://lucasenard.github.io/Data/patients.json"

return None

def on_process_input(self,request):

"""

API にリクエストを行い、検出される患者ごとに Patient オブジェクトを作成し、

ターゲットに送信します。

:param request: サービスに送信されたリクエスト

:return: None

"""

req = requests.get(self.api_url)

if req.status_code == 200:

dat = req.json()

for key,val in dat.items():

patient = Patient()

patient.name = key